Comprendre la falsification de facture, ses signaux clés et les limites des contrôles classiques.

Fonctionnalité

Dernière mise à jour :

January 30, 2026

5 minutes

Les modèles de langage dominent aujourd’hui le débat sur l’IA. Cette trajectoire est pourtant remise en cause par une vision radicalement différente.

Yann Lecun, son avis sur l'avenir de l'IA, et sa vision de l'AGI

Depuis deux ans, les modèles de langage se sont imposés comme la référence dominante en intelligence artificielle. Leur capacité à générer du texte et du code a fait émerger l’idée qu’augmenter leur taille, leurs données et leur puissance de calcul suffirait à atteindre une intelligence de niveau humain.

Cette trajectoire, aujourd’hui largement adoptée par l’industrie, repose sur un postulat rarement interrogé. Pour Yann LeCun, les LLM ne constituent pas une étape naturelle vers une intelligence avancée. Ils mettent au contraire en lumière une limite structurelle de l’IA actuelle : sa difficulté à comprendre le monde réel au-delà des représentations textuelles.

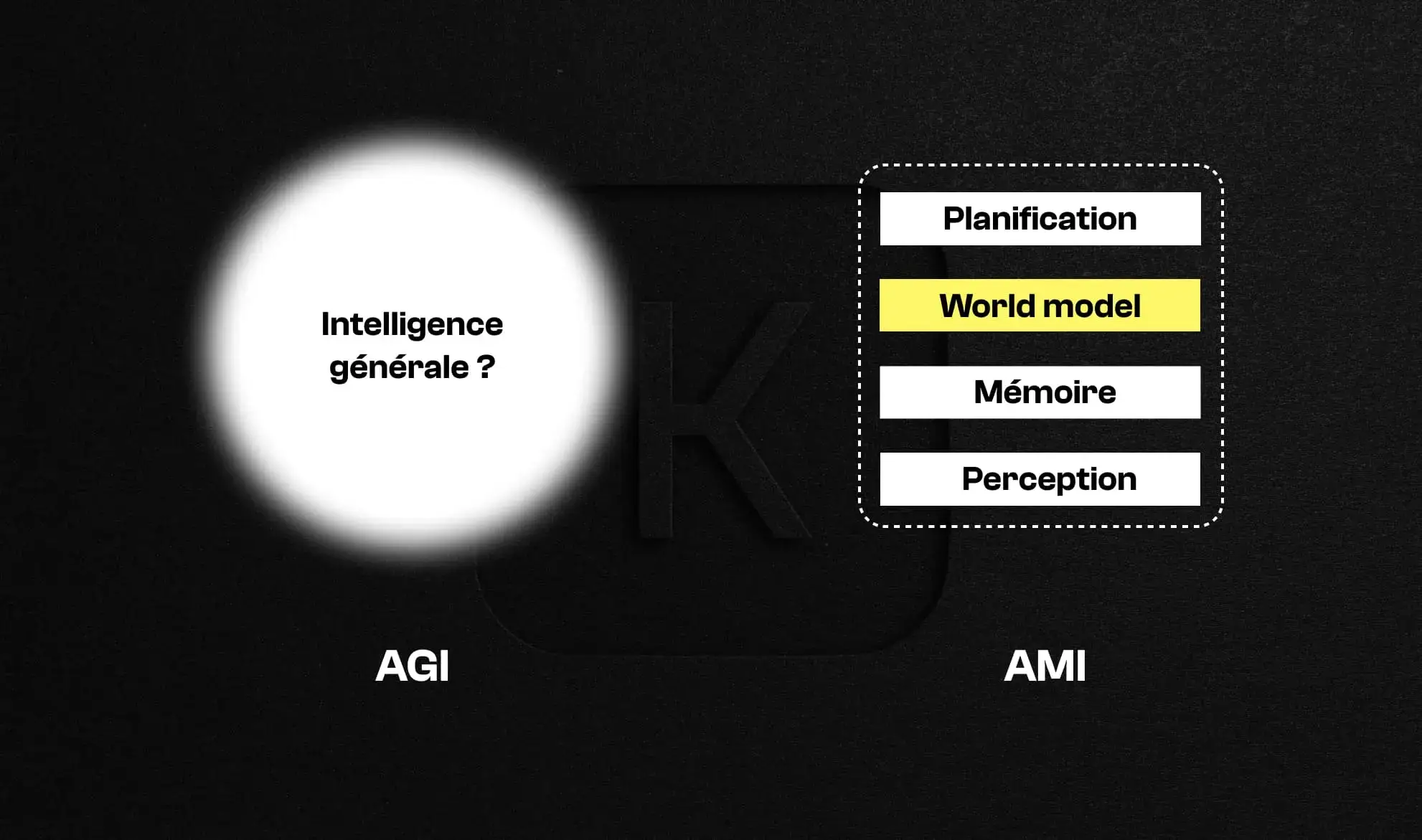

Le terme AGI, pour Artificial General Intelligence, suggère l’idée d’une intelligence universelle, capable de tout comprendre et de s’adapter à n’importe quelle situation. Pour Yann LeCun, cette notion repose sur un malentendu fondamental.

L’intelligence humaine n’est pas générale. Elle est profondément spécialisée, façonnée par la perception, l’action, la mémoire et l’interaction avec un environnement physique. Parler d’AGI revient à projeter une abstraction trompeuse sur des systèmes qui ne partagent ni notre cognition ni notre rapport au monde.

LeCun préfère parler d’AMI, pour Advanced Machine Intelligence, ou de HLI, Human-Level Intelligence. Ce choix n’est pas sémantique. Il recentre la recherche sur des capacités concrètes : percevoir, planifier, raisonner à partir d’un modèle du monde, plutôt que viser une intelligence prétendument générale.

Les mots structurent les objectifs scientifiques. En ce sens, la fascination pour l’AGI tend à masquer les véritables verrous techniques de l’IA contemporaine.

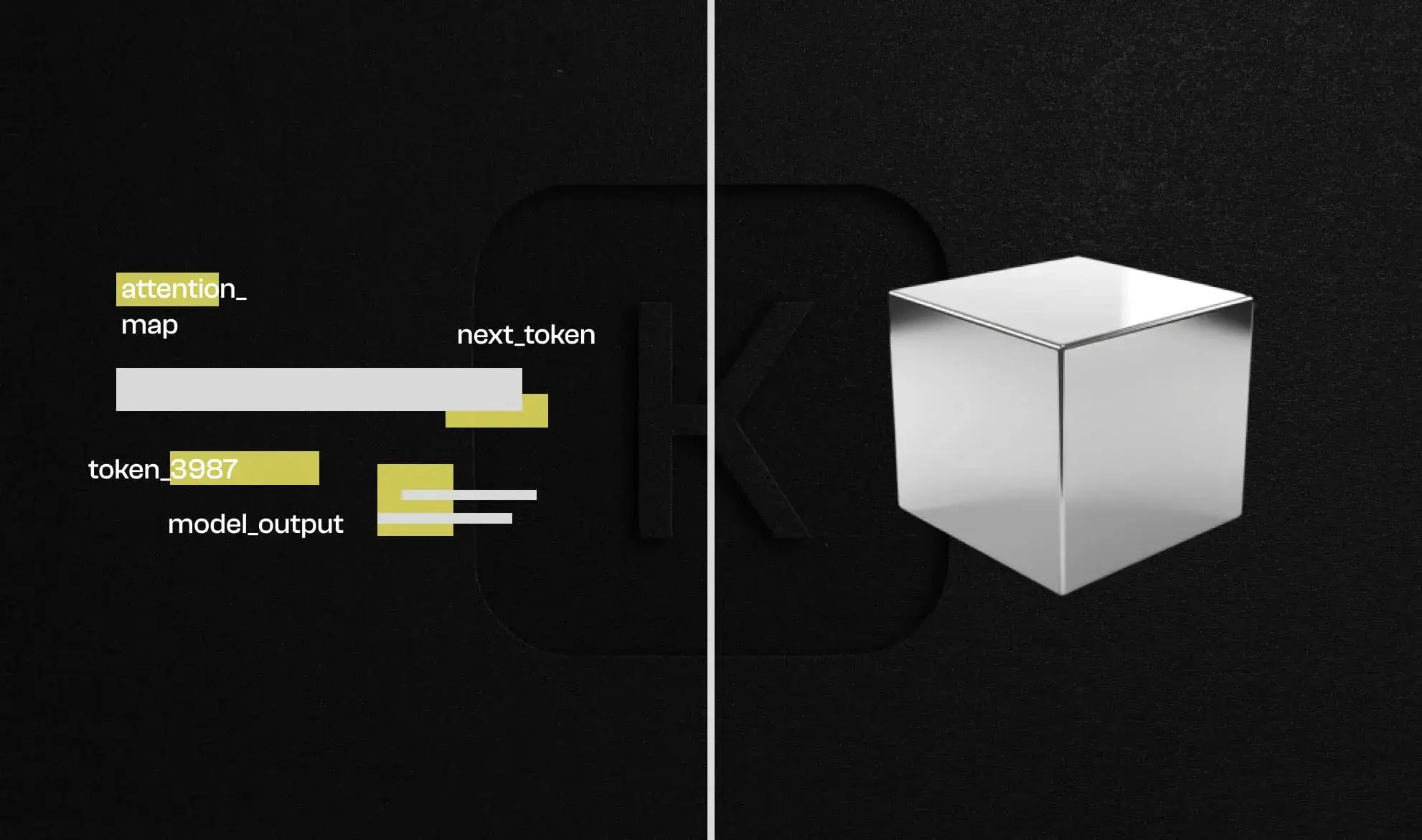

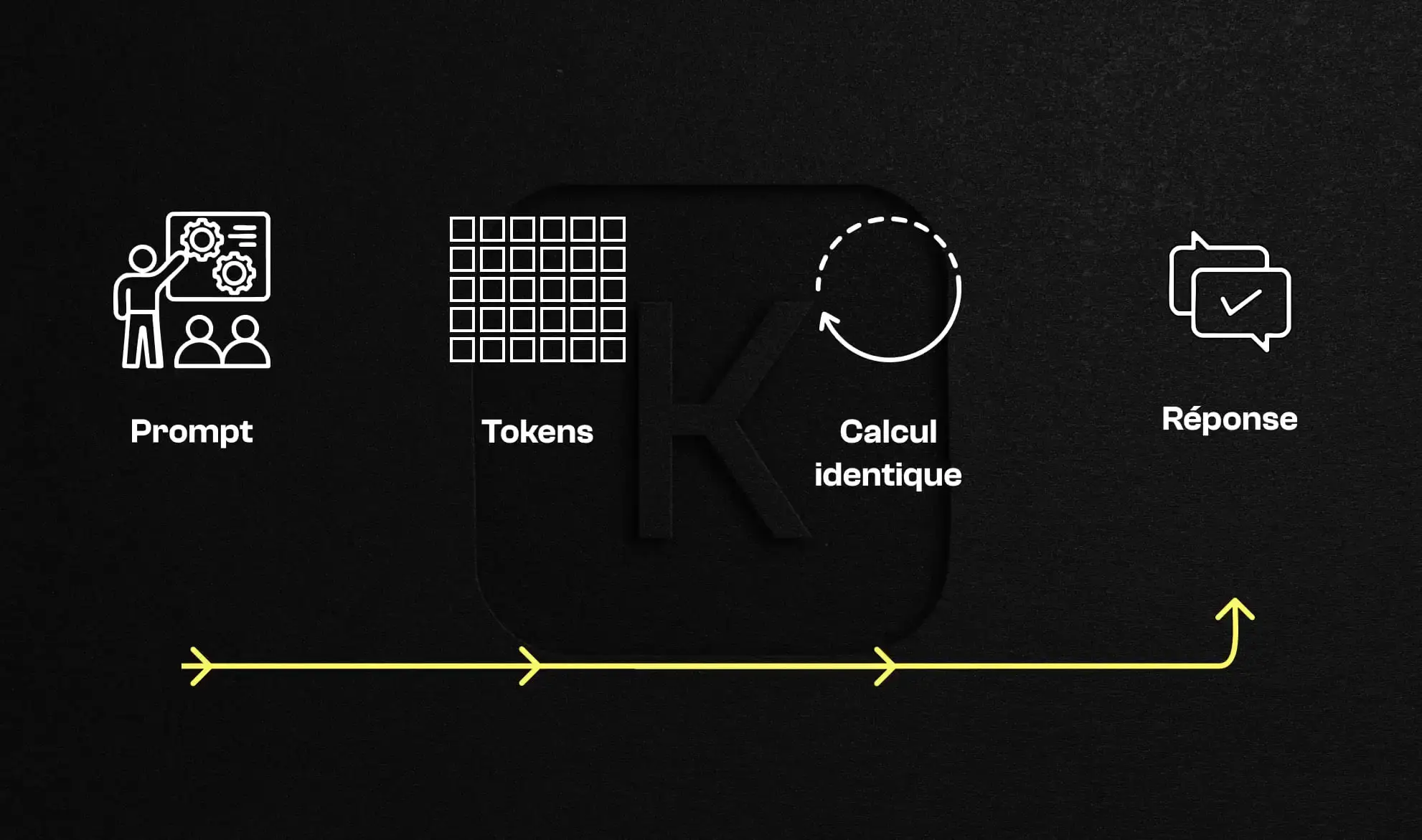

Les LLM reposent tous sur un principe simple : prédire le prochain token à partir des tokens précédents. En apprenant sur des volumes massifs de textes, ils capturent des régularités statistiques impressionnantes et produisent des réponses souvent cohérentes.

Cette efficacité ne doit cependant pas être confondue avec une compréhension du monde. Le modèle ne manipule que des représentations linguistiques. Il ne possède ni notion d’objet, ni causalité physique, ni représentation interne de la réalité.

Un point souvent ignoré concerne le calcul. Pour produire chaque token, un LLM effectue une quantité de calcul fixe. Un problème simple ou complexe est traité de la même manière. Il n’existe pas de mécanisme permettant au modèle de consacrer davantage de ressources à une situation difficile.

Lorsque les LLM semblent raisonner, ils déroulent généralement des schémas appris. Cette apparente intelligence disparaît dès que le problème sort légèrement des cas rencontrés durant l’entraînement.

Le paradoxe de Moravec décrit un constat toujours d’actualité : les tâches que les humains réalisent sans effort conscient sont souvent les plus difficiles à automatiser. À l’inverse, certaines tâches intellectuelles complexes sont relativement faciles pour une machine.

Un modèle d’IA peut résoudre des équations avancées, rédiger un texte juridique ou analyser des données financières. Mais il échoue encore sur des actions élémentaires comme manipuler des objets, anticiper une interaction physique ou comprendre ce qui est possible ou impossible dans le monde réel.

Le raisonnement formel est une construction culturelle récente. Il repose sur des symboles et des règles explicites. Le sens commun, lui, est le produit de millions d’années d’évolution et d’apprentissage par interaction.

Les LLM excellent dans les domaines riches en texte et en règles écrites. Ils échouent là où l’intuition, la perception et la compréhension implicite sont nécessaires.

Ce décalage ne tient pas à une supériorité abstraite de l’intelligence humaine, mais à la manière dont elle se construit.

Un enfant apprend le monde sans lire de manuels. Il observe, expérimente, échoue, corrige. En quelques années, il développe une compréhension intuitive de notions complexes comme la gravité, la permanence des objets ou la causalité.

Cette capacité repose sur l’observation directe du monde, combinée à une mémoire persistante et à une représentation interne de la réalité. C’est précisément ce qui manque aux systèmes actuels.

Même entraînés sur l’ensemble du contenu public d’internet, les LLM n’accèdent qu’à une description indirecte du monde. Le texte ne capture ni la continuité physique, ni les contraintes du réel, ni l’expérience incarnée.

Ce décalage explique pourquoi l’augmentation des données textuelles ne suffit pas à combler les lacunes fondamentales de l’IA actuelle.

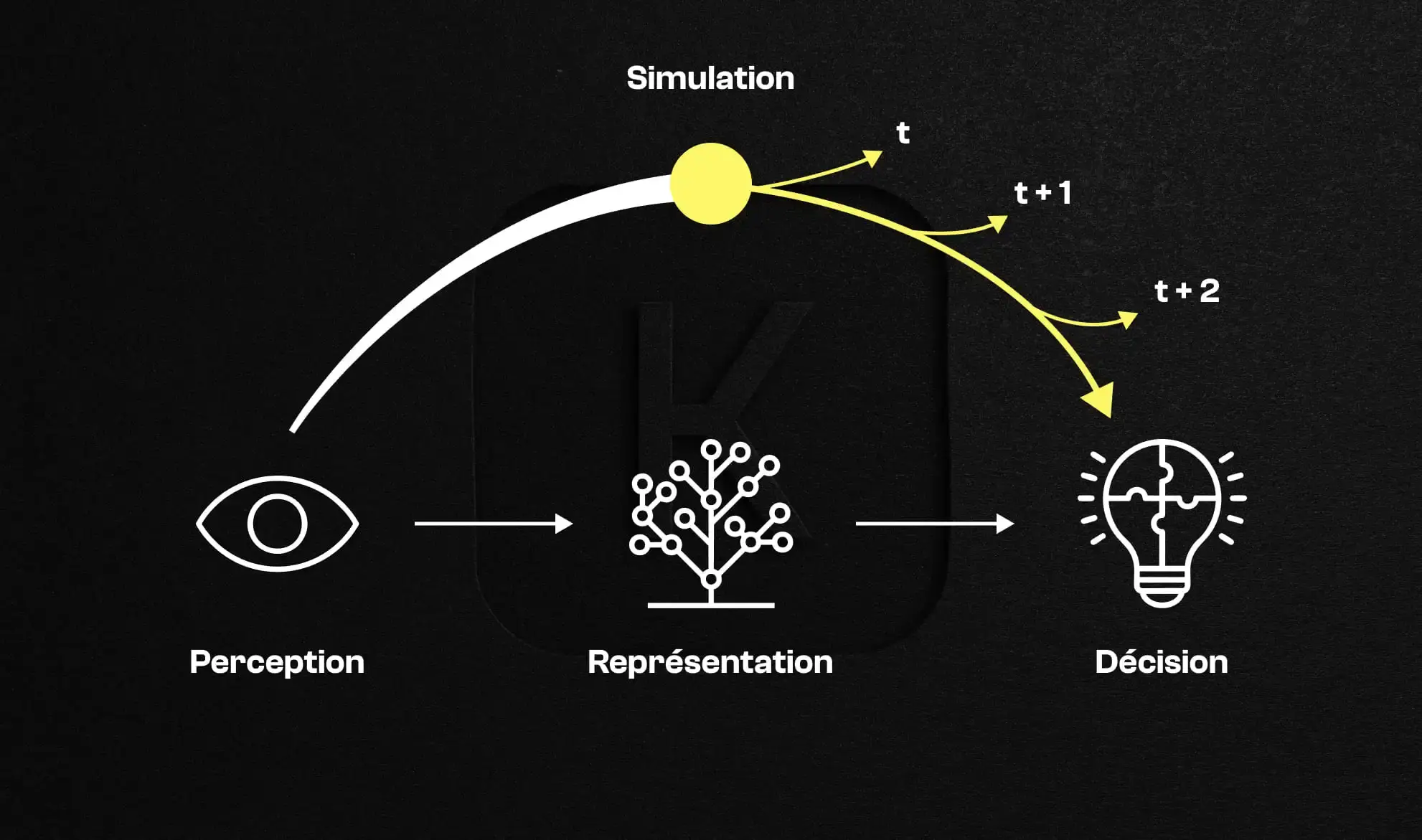

Pour Yann LeCun, une intelligence artificielle réellement avancée doit être capable de construire un modèle interne du monde. Ce world model permet de représenter l’état du réel, d’imaginer plusieurs futurs possibles et d’évaluer les conséquences d’une action avant qu’elle ne soit exécutée.

Cette approche rompt avec la logique des modèles génératifs. L’objectif n’est plus de produire une sortie plausible, mais de simuler la réalité afin de guider la décision.

Un world model articule perception, représentation et prédiction dans une boucle continue. Le système observe le monde, en construit une représentation abstraite, simule différents scénarios futurs, puis sélectionne l’action la plus adaptée en fonction de ses objectifs et de ses contraintes.

C’est ce mécanisme de simulation interne, central dans le raisonnement humain et animal, qui fait aujourd’hui défaut aux modèles de langage.

Comprendre le monde n’est cependant pas qu’une question de modèle interne. Cela implique aussi de repenser les architectures elles-mêmes.

Les modèles génératifs cherchent à reconstruire des données, qu’il s’agisse de texte, d’images ou de vidéos. Cette approche fonctionne bien pour produire du contenu, mais elle échoue à extraire les abstractions nécessaires à la compréhension du monde.

Prédire des pixels ou des mots ne suffit pas à saisir les relations causales sous-jacentes.

LeCun plaide pour des architectures capables de représenter ce qui est pertinent et prédictible, en ignorant le bruit. Cette capacité d’abstraction est essentielle pour passer de la perception à la compréhension.

Les architectures JEPA reposent sur la prédiction de représentations abstraites plutôt que sur la génération brute. Elles permettent de mesurer la compatibilité entre un état du monde et un objectif, puis d’optimiser une séquence d’actions.

Cette inférence par optimisation rapproche l’IA du raisonnement humain, en lui donnant la capacité de planifier et d’anticiper.

En intégrant des objectifs et des garde-fous explicites, cette approche permet de concevoir des systèmes plus contrôlables, capables de respecter des contraintes tout en poursuivant un but.

Au-delà de la recherche, Yann LeCun insiste sur l’importance de l’open source. Une IA contrôlée par quelques acteurs centralisés poserait des risques majeurs en termes de souveraineté, de diversité linguistique et de démocratie.

Développer des architectures ouvertes est une condition essentielle pour un futur de l’IA distribué et pluraliste.

Avant de raisonner, une IA doit percevoir correctement. Dans le monde réel, les données sont imparfaites, bruitées, hétérogènes. Les documents, en particulier, constituent l’un des premiers terrains où cette compréhension est mise à l’épreuve.

La frontière entre une IA spectaculaire et une IA réellement opérationnelle se joue souvent à ce niveau : comprendre fidèlement le réel avant de tenter de l’automatiser.

L’avenir de l’intelligence artificielle ne se jouera pas uniquement sur la taille des modèles ou la qualité de la génération. Il dépendra de la capacité des systèmes à comprendre le monde, à en construire une représentation cohérente et à agir de manière raisonnée.

La trajectoire défendue par Yann LeCun est plus exigeante, plus lente, mais probablement plus robuste. Elle rappelle une évidence souvent oubliée : avant d’imiter l’intelligence humaine, encore faut-il comprendre comment elle se construit.

Passez à l’automatisation des documents

Avec Koncile, automatisez vos extractions, réduisez les erreurs et optimisez votre productivité en quelques clics grâce à un l'OCR IA.

Les ressources Koncile

Comprendre la falsification de facture, ses signaux clés et les limites des contrôles classiques.

Fonctionnalité

Pourquoi les documents chauffeur et véhicule ralentissent l’intégration à grande échelle.

Fonctionnalité

Comment des signaux techniques faibles révèlent les risques de fraude documentaire.

Fonctionnalité