Wie Rechnungsbetrug funktioniert, typische Warnsignale und warum klassische Kontrollen nicht ausreichen.

Funktion

Letzte Aktualisierung:

January 30, 2026

5 Minuten

Sprachmodelle dominieren heute die Debatte über künstliche Intelligenz. Doch diese Entwicklung wird durch eine radikal andere Vision infrage gestellt.

Yann LeCuns Vision für die Zukunft der KI jenseits von LLMs und AGI.

In den vergangenen zwei Jahren haben sich Sprachmodelle als dominierender Referenzpunkt der künstlichen Intelligenz etabliert. Ihre Fähigkeit, Texte und Code zu generieren, hat die Vorstellung genährt, dass größere Modelle, mehr Daten und höhere Rechenleistung ausreichen würden, um menschenähnliche Intelligenz zu erreichen.

Diese Entwicklung, die heute von großen Teilen der Industrie übernommen wird, beruht auf einer Annahme, die selten hinterfragt wird. Für Yann LeCun stellen LLMs keinen natürlichen Schritt hin zu fortgeschrittener Intelligenz dar. Im Gegenteil: Sie machen eine strukturelle Schwäche heutiger KI-Systeme sichtbar – ihre Unfähigkeit, die reale Welt jenseits textueller Repräsentationen zu verstehen.

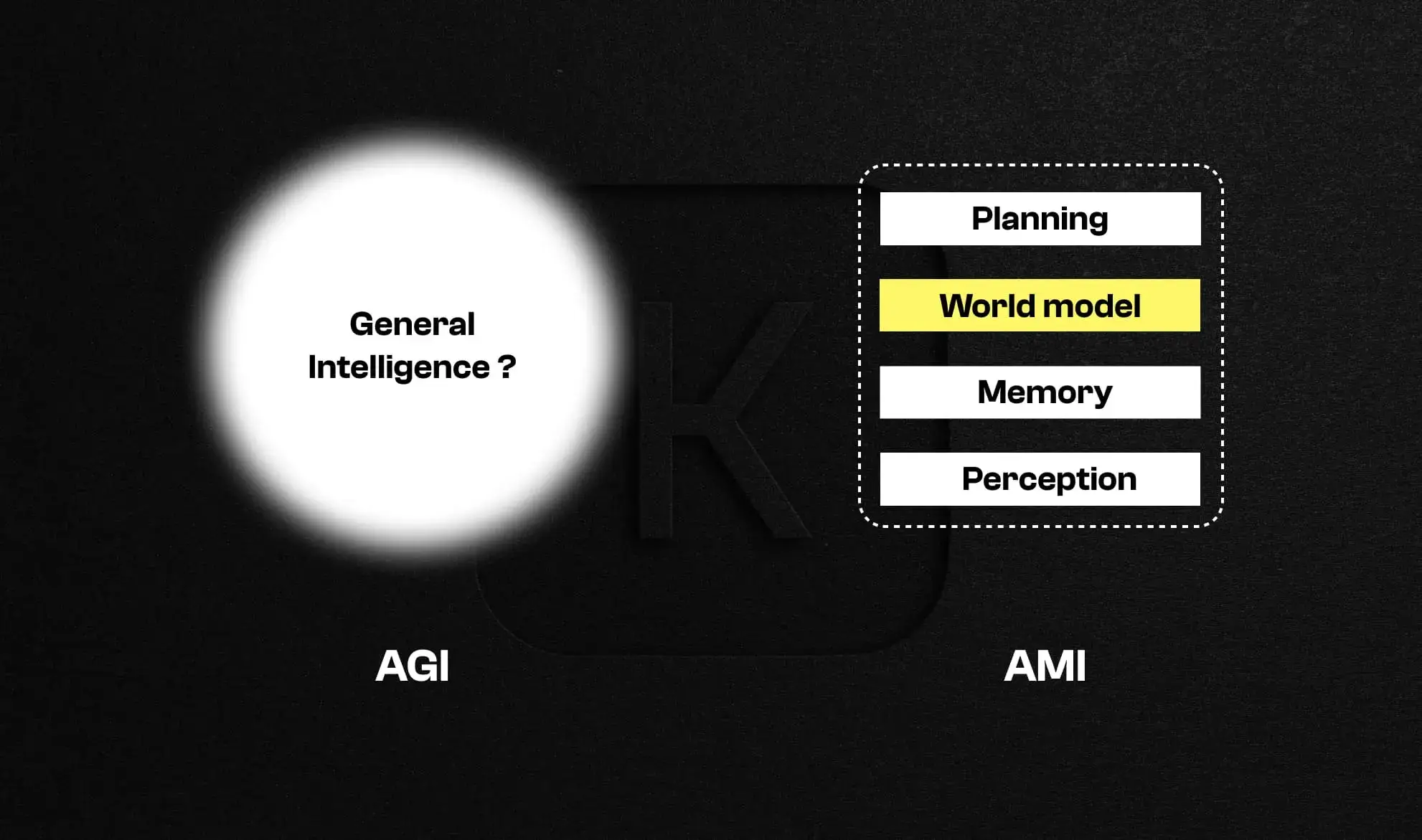

Der Begriff AGI, Artificial General Intelligence, suggeriert eine universelle Intelligenz, die jede Situation verstehen und sich anpassen kann. Für Yann LeCun beruht dieses Konzept auf einem grundlegenden Missverständnis.

Menschliche Intelligenz ist nicht allgemein. Sie ist hochgradig spezialisiert und wird durch Wahrnehmung, Handlung, Gedächtnis und die kontinuierliche Interaktion mit einer physischen Umwelt geformt. Von AGI zu sprechen bedeutet, eine irreführende Abstraktion auf Systeme zu projizieren, die weder unsere Kognition noch unser Verhältnis zur Welt teilen.

LeCun bevorzugt den Begriff AMI, Advanced Machine Intelligence, oder HLI, Human-Level Intelligence. Diese Wahl ist nicht bloß semantisch. Sie rückt konkrete Fähigkeiten in den Mittelpunkt der Forschung: Wahrnehmen, Planen und Schlussfolgern auf Basis eines Weltmodells, anstatt einer vermeintlich allgemeinen Intelligenz nachzujagen.

Begriffe strukturieren wissenschaftliche Ziele. In diesem Sinne verdeckt die Faszination für AGI häufig die tatsächlichen technischen Hürden der heutigen KI.

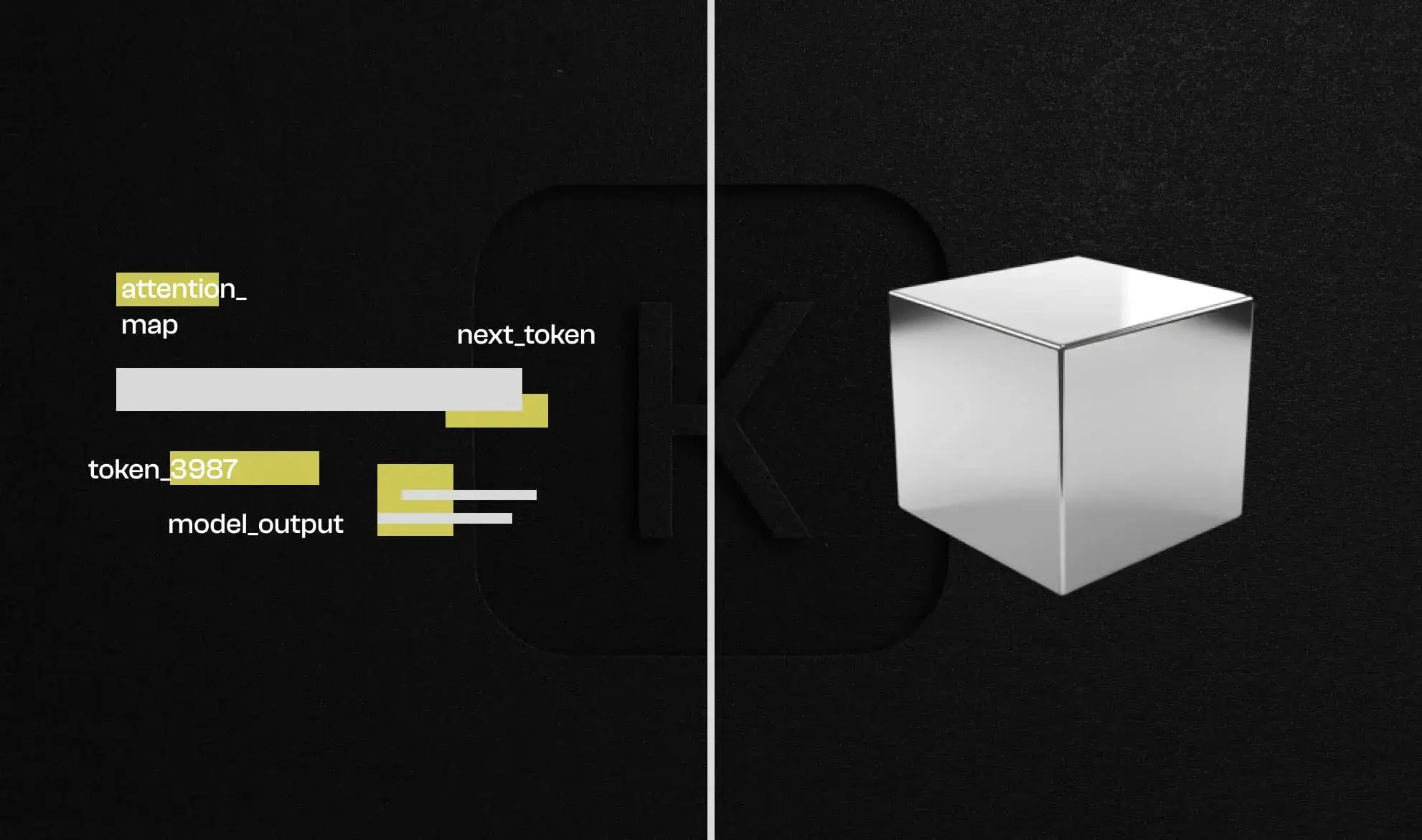

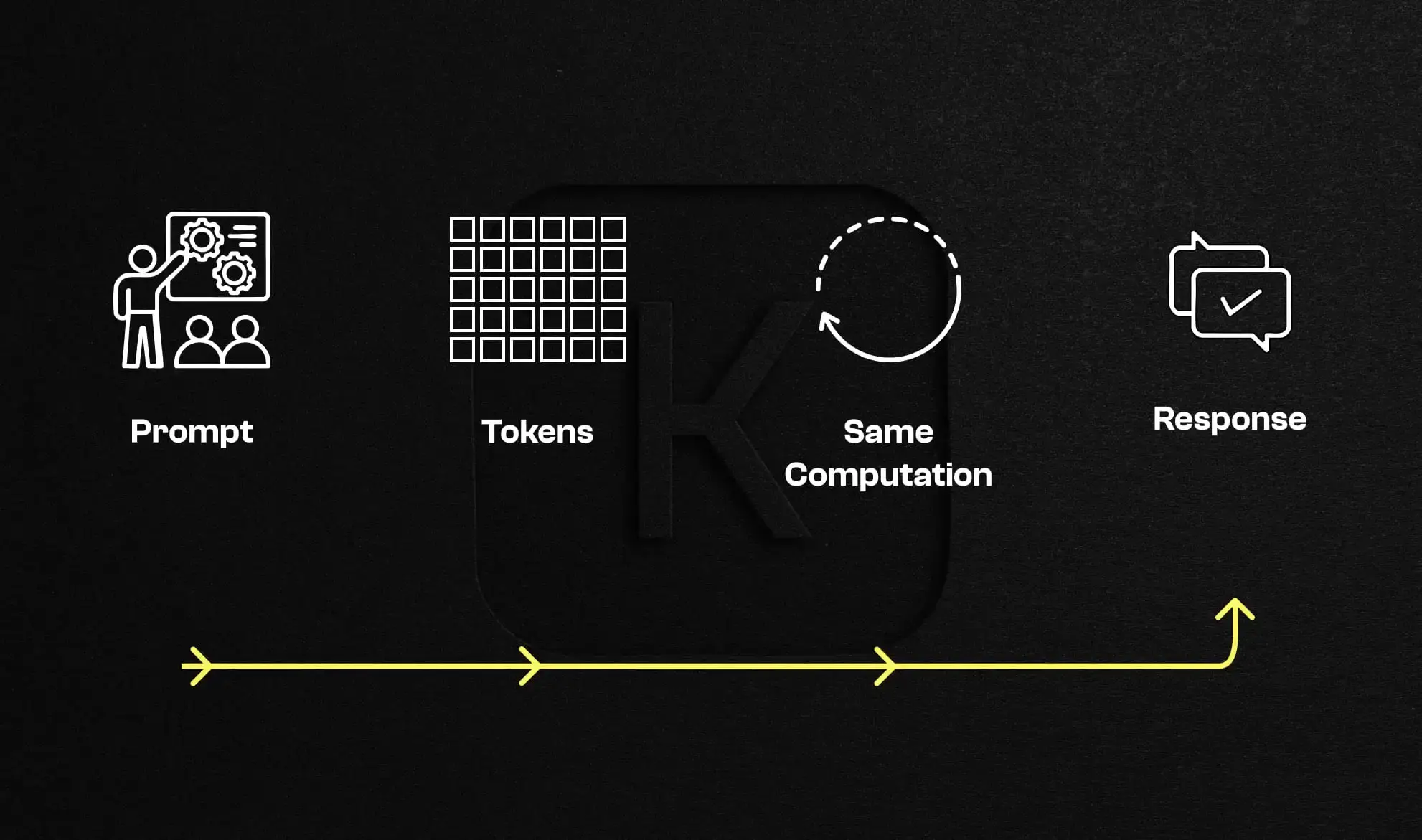

Alle großen Sprachmodelle beruhen auf einem einfachen Mechanismus: der Vorhersage des nächsten Tokens auf Basis vorheriger Tokens. Durch das Training auf riesigen Textmengen erfassen sie statistische Regelmäßigkeiten und erzeugen häufig kohärent wirkende Antworten.

Diese Leistungsfähigkeit darf jedoch nicht mit einem Weltverständnis verwechselt werden. Das Modell verarbeitet ausschließlich sprachliche Repräsentationen. Es besitzt weder Objektbegriffe noch physikalische Kausalität oder eine interne Repräsentation der Realität.

Ein oft übersehener Aspekt betrifft die Berechnung selbst. Für jedes Token wird eine feste Menge an Rechenleistung aufgewendet. Ein einfaches oder komplexes Problem wird auf identische Weise behandelt. Es existiert kein Mechanismus, der dem Modell erlaubt, bei schwierigen Situationen mehr Ressourcen einzusetzen.

Wenn LLMs zu „denken“ scheinen, reproduzieren sie meist erlernte Muster. Diese scheinbare Intelligenz bricht zusammen, sobald ein Problem geringfügig von den Trainingsdaten abweicht.

Das Moravec-Paradoxon beschreibt eine bis heute gültige Beobachtung: Aufgaben, die Menschen mühelos ausführen, sind für Maschinen oft besonders schwer zu automatisieren, während bestimmte komplexe intellektuelle Aufgaben vergleichsweise leicht sind.

Ein KI-System kann komplexe Gleichungen lösen, juristische Texte verfassen oder Finanzdaten analysieren. Gleichzeitig scheitert es an grundlegenden Handlungen wie dem Manipulieren von Objekten, dem Antizipieren physischer Interaktionen oder dem Verständnis dessen, was in der realen Welt möglich oder unmöglich ist.

Formales Denken ist eine relativ junge kulturelle Errungenschaft. Es basiert auf expliziten Symbolen und Regeln. Alltagsverstand hingegen ist das Ergebnis von Millionen Jahren evolutionärer Entwicklung und Lernen durch Interaktion.

LLMs sind stark in textreichen, regelbasierten Domänen. Sie versagen dort, wo Intuition, Wahrnehmung und implizites Verständnis erforderlich sind.

Diese Kluft ist nicht Ausdruck einer abstrakten Überlegenheit menschlicher Intelligenz, sondern eine Folge ihrer Entstehungsweise.

Ein Kind lernt die Welt, ohne Handbücher zu lesen. Durch Beobachtung, Experimentieren, Scheitern und Korrigieren entwickelt es innerhalb weniger Jahre ein intuitives Verständnis komplexer Konzepte wie Schwerkraft, Objektpermanenz oder Kausalität.

Diese Fähigkeit beruht auf direkter Interaktion mit der Umwelt, kombiniert mit dauerhaftem Gedächtnis und einer internen Repräsentation der Realität. Genau das fehlt heutigen KI-Systemen.

Selbst wenn LLMs auf dem gesamten öffentlich verfügbaren Internet trainiert werden, erhalten sie lediglich eine indirekte Beschreibung der Welt. Text erfasst weder physische Kontinuität noch reale Einschränkungen oder verkörperte Erfahrung.

Dieses Defizit erklärt, warum eine bloße Erhöhung der Textdaten grundlegende Schwächen aktueller KI nicht behebt.

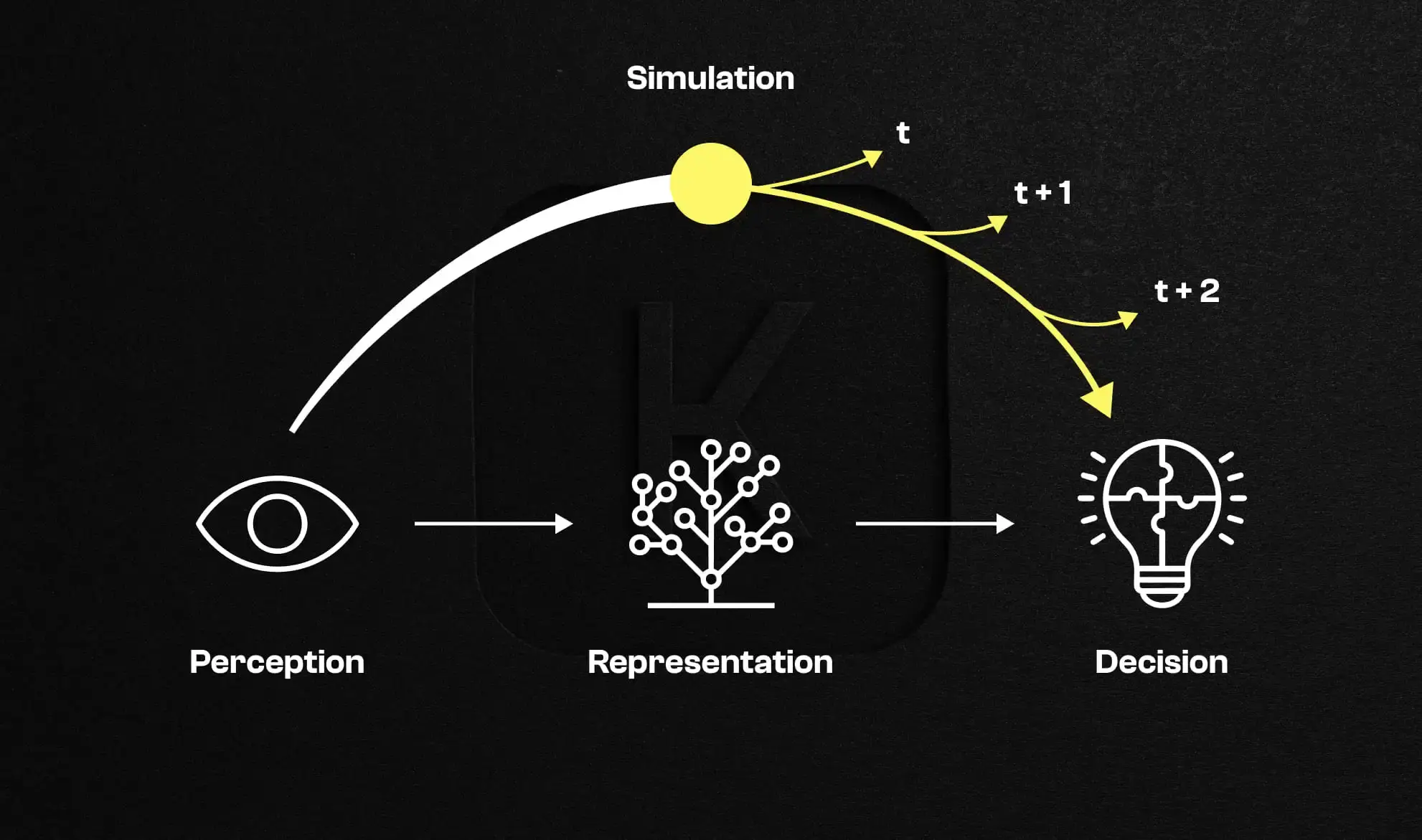

Für Yann LeCun muss eine wirklich fortgeschrittene KI in der Lage sein, ein internes Weltmodell aufzubauen. Dieses World Model repräsentiert den Zustand der Realität, simuliert mögliche Zukünfte und bewertet die Konsequenzen von Handlungen, bevor sie ausgeführt werden.

Dieser Ansatz unterscheidet sich grundlegend von generativen Modellen. Ziel ist nicht mehr die Erzeugung plausibler Ausgaben, sondern die Simulation der Realität zur Steuerung von Entscheidungen.

Ein World Model verbindet Wahrnehmung, Repräsentation und Vorhersage in einer kontinuierlichen Schleife. Das System beobachtet die Welt, konstruiert eine abstrakte Darstellung, simuliert mehrere Zukunftsszenarien und wählt die passendste Handlung anhand von Zielen und Einschränkungen aus.

Dieser Mechanismus interner Simulation, zentral für menschliches und tierisches Denken, fehlt Sprachmodellen bislang.

Die Welt zu verstehen ist jedoch nicht nur eine Frage interner Modelle. Es erfordert auch ein grundlegendes Umdenken in der Architektur.

Generative Modelle versuchen, Daten zu rekonstruieren – seien es Texte, Bilder oder Videos. Dieser Ansatz eignet sich zur Inhaltserzeugung, versagt jedoch bei der Extraktion kausaler Abstraktionen.

Pixel oder Wörter vorherzusagen reicht nicht aus, um zugrunde liegende Ursache-Wirkungs-Beziehungen zu erfassen.

LeCun plädiert für Architekturen, die Relevantes und Vorhersagbares repräsentieren und Rauschen ignorieren. Diese Fähigkeit zur Abstraktion ist entscheidend, um von Wahrnehmung zu Verständnis zu gelangen.

JEPA-Architekturen basieren auf der Vorhersage abstrakter Repräsentationen statt auf roher Generierung. Sie ermöglichen es, die Übereinstimmung zwischen einem Weltzustand und einem Ziel zu bewerten und anschließend eine Abfolge von Handlungen zu optimieren.

Diese Form der Inferenz durch Optimierung bringt KI näher an menschliches Denken, indem sie Planung und Antizipation erlaubt.

Durch die Integration expliziter Ziele und Schutzmechanismen lassen sich besser kontrollierbare Systeme entwickeln, die Einschränkungen respektieren und gleichzeitig ein Ziel verfolgen.

Über die Forschung hinaus betont Yann LeCun die Bedeutung von Open Source. Eine KI, die von wenigen zentralisierten Akteuren kontrolliert wird, birgt erhebliche Risiken für Souveränität, sprachliche Vielfalt und demokratische Strukturen.

Offene Architekturen zu entwickeln ist eine wesentliche Voraussetzung für eine verteilte und pluralistische KI-Zukunft.

Bevor eine KI schlussfolgern kann, muss sie korrekt wahrnehmen. In der realen Welt sind Daten unvollständig, verrauscht und heterogen. Dokumente stellen eines der ersten Felder dar, in denen dieses Verständnis auf die Probe gestellt wird.

Die Grenze zwischen spektakulärer KI und wirklich operativer KI verläuft häufig genau hier: die Realität zuverlässig zu erfassen, bevor man versucht, sie zu automatisieren.

Die Zukunft der künstlichen Intelligenz wird nicht allein durch Modellgröße oder generative Qualität bestimmt. Sie hängt davon ab, ob Systeme die Welt verstehen, kohärente interne Repräsentationen aufbauen und begründet handeln können.

Der von Yann LeCun vertretene Weg ist anspruchsvoller und langsamer, aber vermutlich robuster. Er erinnert an eine oft vergessene Wahrheit: Bevor man menschliche Intelligenz imitiert, muss man verstehen, wie sie entsteht.

Wechseln Sie zur Dokumentenautomatisierung

Automatisieren Sie mit Koncile Ihre Extraktionen, reduzieren Sie Fehler und optimieren Sie Ihre Produktivität dank KI OCR mit wenigen Klicks.

Ressourcen von Koncile

Wie Rechnungsbetrug funktioniert, typische Warnsignale und warum klassische Kontrollen nicht ausreichen.

Funktion

Warum Fahrer- und Fahrzeugdokumente die Integration im großen Maßstab verlangsamen.

Funktion

Wie schwache technische Signale Dokumentenbetrug sichtbar machen.

Funktion