Yann Lecun, son avis sur l'avenir de l'IA, et sa vision de l'AGI

Comparatifs

Dernière mise à jour :

December 22, 2025

5 minutes

Le AI Act impose une nouvelle logique : toute IA utilisée en Europe doit être explicable, traçable et maîtrisée. Dès 2026, ce qui relevait hier de l’expérimentation ou de l’automatisation opaque devient un risque juridique, financier et réputationnel. Pour les entreprises, la question n’est plus si elles sont concernées, mais si leurs projets IA seront prêts à temps.

Le AI Act européen encadre l’IA par le risque. Découvrez ce qui change pour les entreprises, les sanctions et les décisions à prendre.

Le AI Act ne régule pas l’intelligence artificielle de manière uniforme. Il repose sur une logique simple mais structurante : plus l’impact potentiel d’un système d’IA sur les individus, les droits ou la société est élevé, plus les exigences réglementaires sont strictes.

Cette approche marque une rupture nette avec les régulations technologiques précédentes. Il ne s’agit plus de savoir si une entreprise utilise de l’IA ou non, mais comment, où et avec quelles conséquences. Autrement dit, ce n’est pas la technologie en elle-même qui est jugée, mais son usage concret dans un contexte donné.

Dans ce contexte, beaucoup parlent du AI Act sans l’avoir réellement lu. Ce n’est pas surprenant : le texte est long, dense, juridique. Mais bonne nouvelle : il n’est pas nécessaire de lire l’intégralité du règlement pour en comprendre la logique opérationnelle.

Même les versions “simplifiées” publiées par la Commission européenne restent difficiles à exploiter pour des équipes produit, tech ou métier. C’est précisément pour cette raison qu’il est plus efficace de raisonner par questions successives, en suivant la grille de lecture du risque.

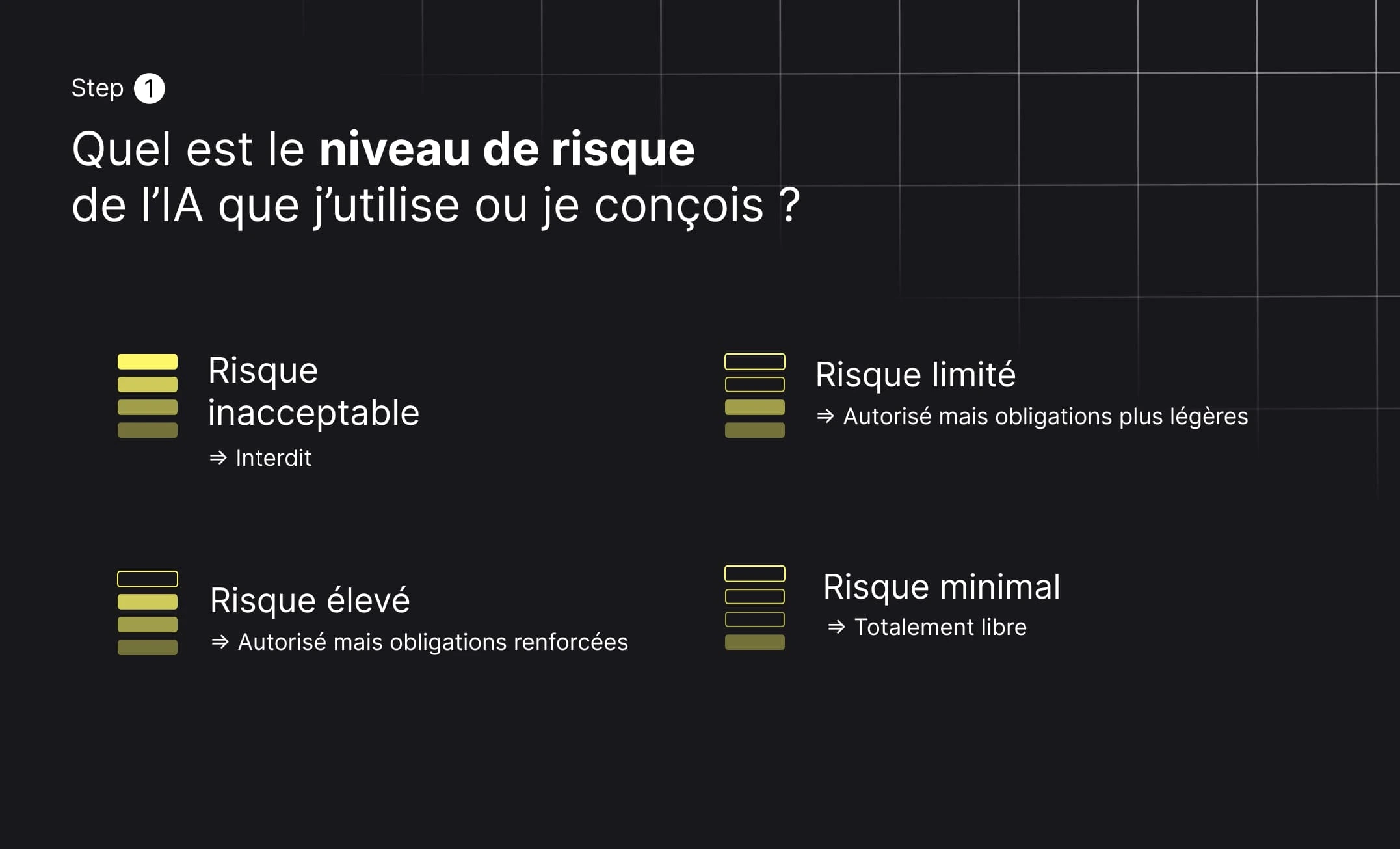

Le cœur du règlement repose sur une classification en quatre niveaux. C’est le point de départ indispensable pour toute analyse de conformité. Cette logique de segmentation par le risque fait directement écho aux enjeux de document categorization, indispensables pour identifier les flux sensibles, appliquer les bons contrôles et prioriser les efforts de conformité.

Risque inacceptable – interdit

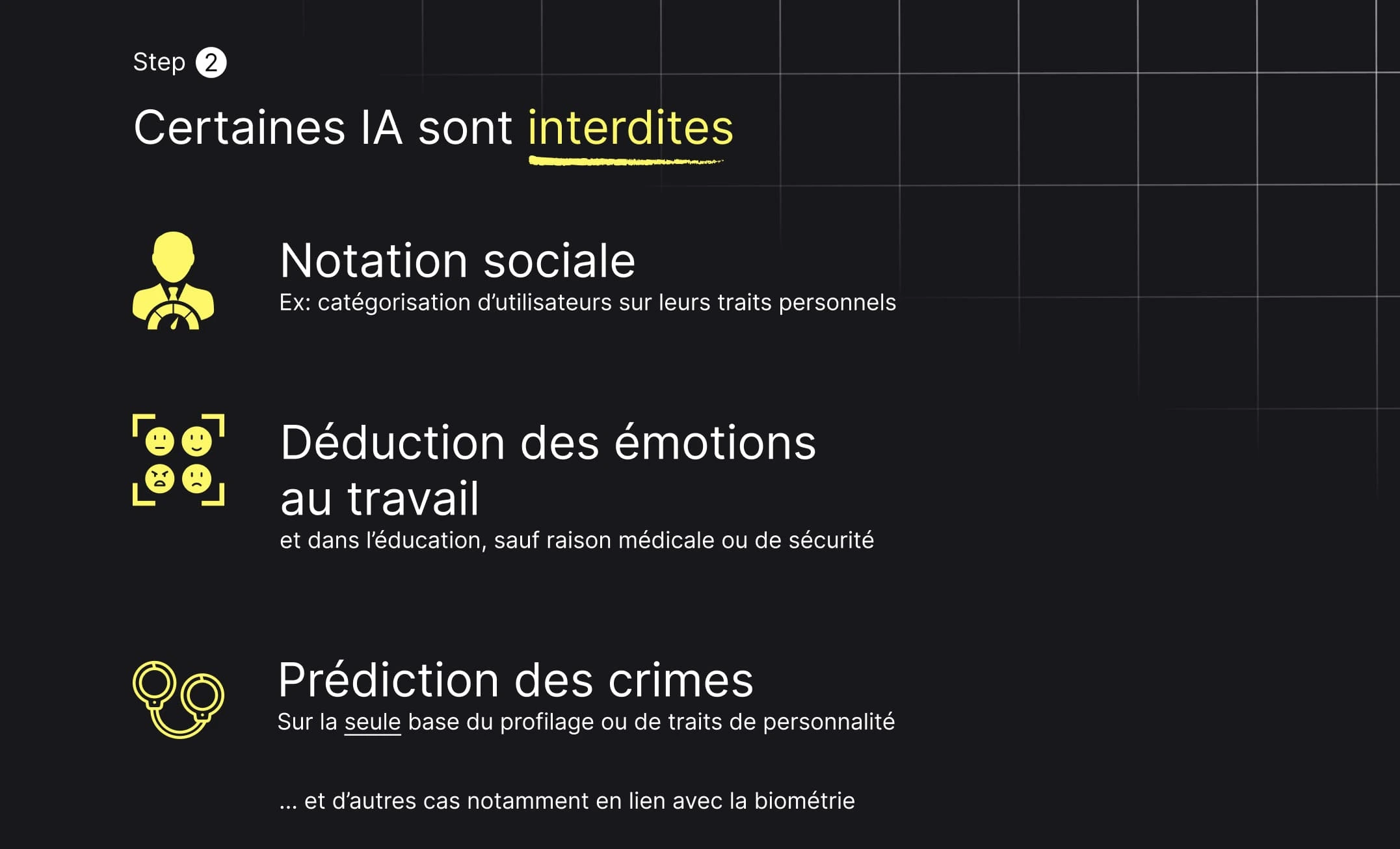

Certains usages sont purement et simplement bannis car jugés incompatibles avec les droits fondamentaux. Cela inclut notamment la notation sociale des individus, la prédiction criminelle fondée sur le profilage, la reconnaissance faciale en temps réel sans cadre strict, ou encore la détection des émotions sur le lieu de travail ou dans l’éducation.

Risque élevé – autorisé mais strictement encadré

Ces systèmes sont autorisés, mais uniquement sous conditions. Ils concernent des domaines où une erreur algorithmique peut avoir des conséquences majeures : santé, recrutement, crédit, assurance, justice, infrastructures critiques ou gestion des migrations. Ici, le AI Act impose des obligations fortes en matière de gouvernance, de supervision et de documentation.

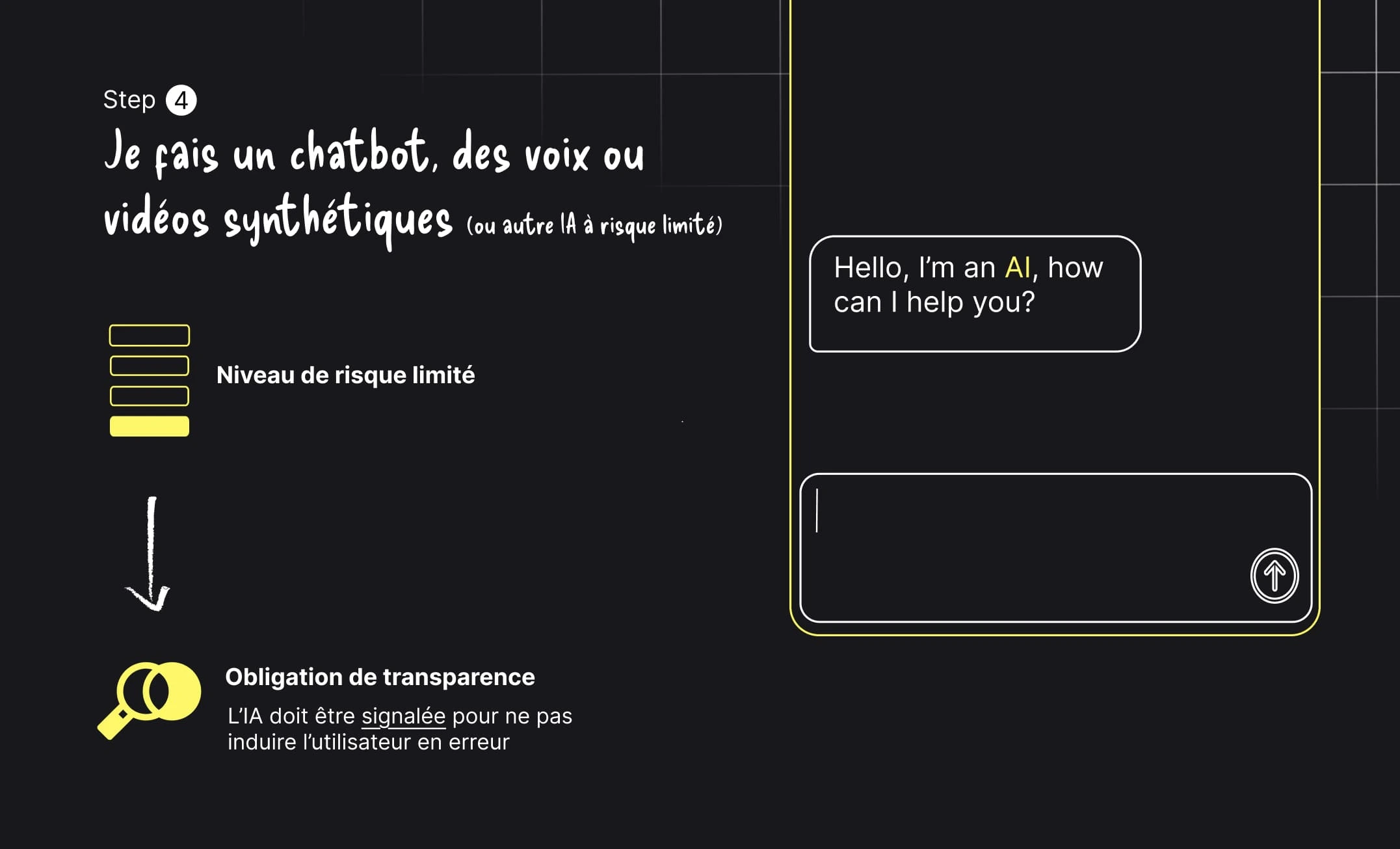

Risque limité – obligation de transparence

Lorsque l’IA interagit directement avec un humain, l’utilisateur doit en être clairement informé. L’objectif est d’éviter toute confusion ou manipulation involontaire. C’est le cas des chatbots, des voix synthétiques ou des contenus générés artificiellement.

Risque minimal – libre usage

Les usages à faible impact, comme les filtres anti-spam, certains moteurs de recommandation ou des applications ludiques, restent libres de toute obligation spécifique.

Avant d’entrer dans des analyses complexes, le AI Act permet d’éliminer rapidement certains cas. Si un système entre dans la catégorie des usages interdits, la question de la conformité ne se pose même pas : il doit être abandonné ou profondément repensé.

La plupart des entreprises découvrent à ce stade qu’elles ne sont pas concernées par ces interdictions. Si votre IA ne note pas les citoyens, ne tente pas de prédire des crimes sur la base de traits personnels et n’analyse pas les émotions des salariés, vous pouvez passer à l’étape suivante. Cette clarification joue un rôle important : elle permet de désamorcer une partie de l’anxiété autour du règlement.

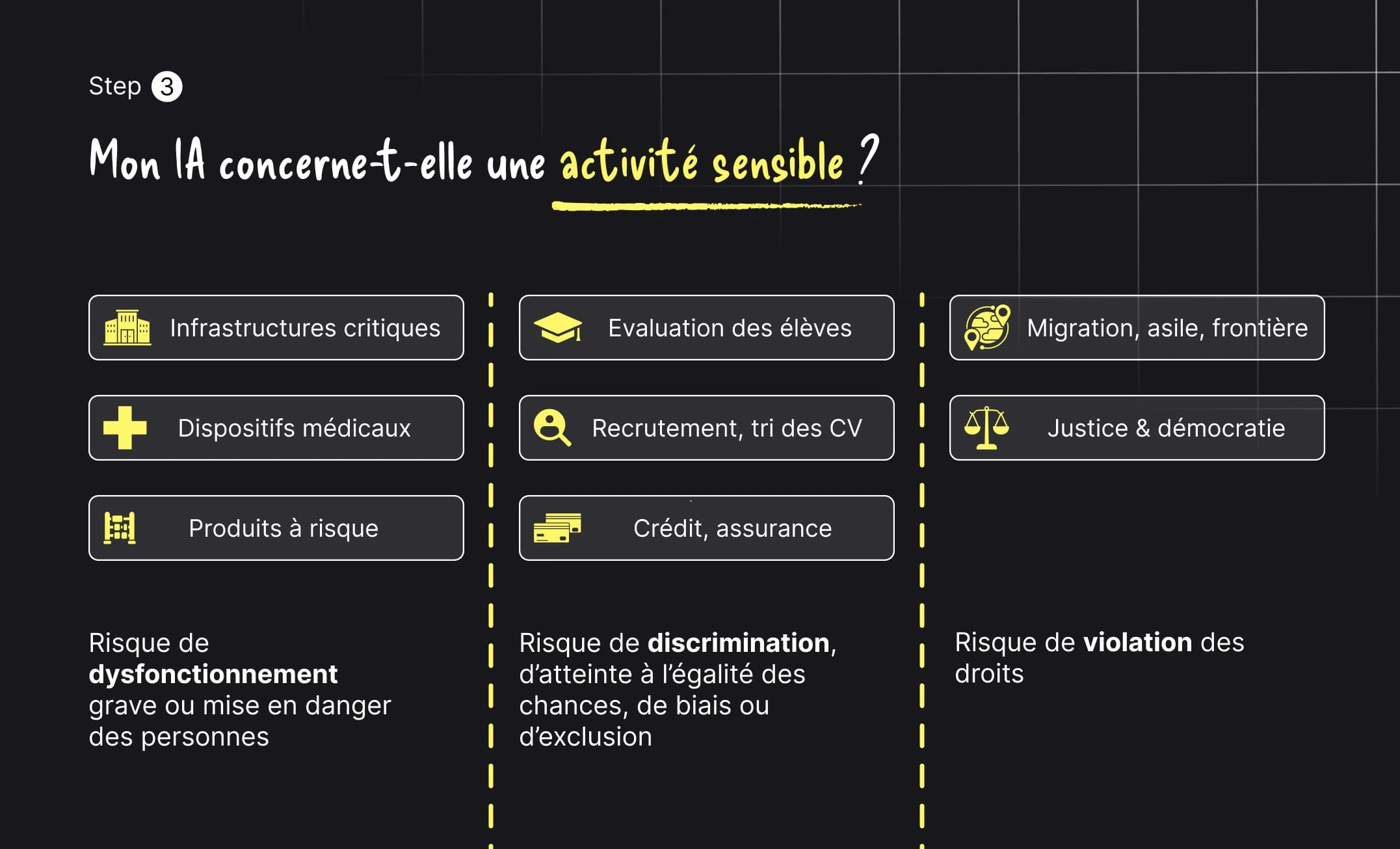

La vraie zone de vigilance commence lorsque l’IA est utilisée dans des activités dites sensibles. Dans de nombreux cas, ces systèmes reposent sur l’analyse de documents non structurés ou semi-structurés, qu’il s’agisse de dossiers médicaux, de pièces administratives, de documents financiers ou de justificatifs d’identité. Ces flux nécessitent souvent une étape de OCR pour transformer l’information brute en données exploitables, ce qui renforce encore les enjeux de fiabilité, de traçabilité et de contrôle humain dans un cadre réglementaire comme celui du AI Act.

Les infrastructures critiques, les dispositifs médicaux ou les produits à risque exposent directement à des dangers physiques. Les systèmes d’évaluation des élèves, de recrutement, de tri de CV, de crédit ou d’assurance présentent quant à eux des risques élevés de discrimination ou d’atteinte à l’égalité des chances. Enfin, les usages liés à la migration, à la justice ou aux processus démocratiques touchent directement aux droits fondamentaux.

Dans ces contextes, l’IA n’est plus un simple outil d’optimisation : elle devient un acteur décisionnel qui doit être encadré.

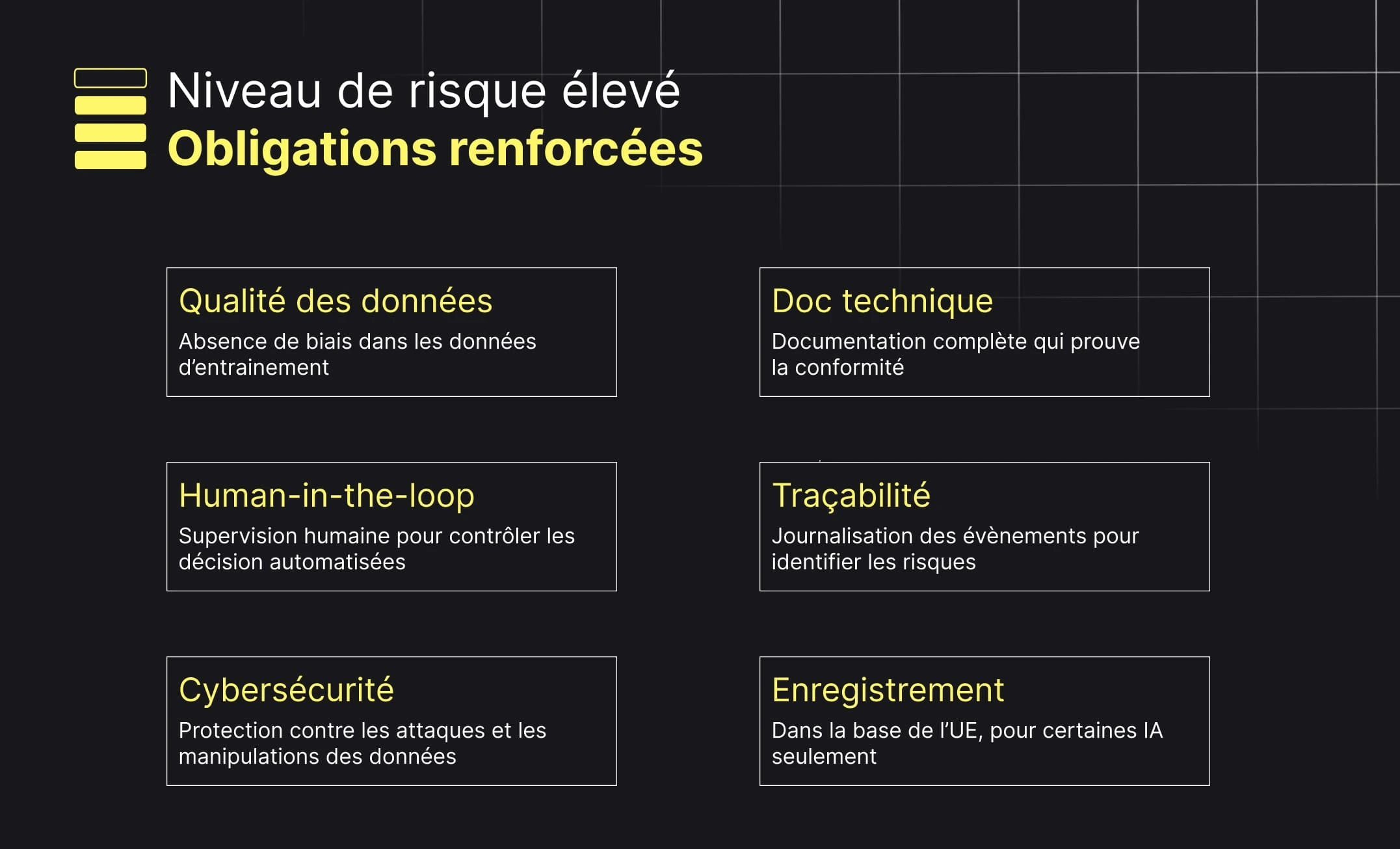

Lorsqu’un système est classé à haut risque, le AI Act ne laisse aucune place à l’improvisation. La conformité repose sur des exigences opérationnelles très précises.

Les entreprises devront démontrer la qualité et l’absence de biais dans leurs données d’entraînement, maintenir une documentation technique complète, garantir une supervision humaine effective, assurer la traçabilité des décisions, protéger les systèmes contre les attaques et, dans certains cas, enregistrer leurs modèles dans une base européenne dédiée.

Ces obligations transforment profondément la manière de concevoir des systèmes d’IA. Elles favorisent les architectures structurées, auditées et gouvernables, au détriment des approches “boîte noire”. Cette évolution s’inscrit pleinement dans la logique de l’intelligent document processing, qui vise à rendre les systèmes décisionnels traçables, explicables et maîtrisables à l’échelle de l’entreprise.

Tous les projets ne relèvent pas du haut risque. De nombreux cas d’usage courants, notamment autour de l’IA générative, entrent dans la catégorie du risque limité.

Dans ces situations, l’exigence principale est simple mais non négociable : la transparence. L’utilisateur doit savoir qu’il interagit avec une IA ou qu’il consomme un contenu généré artificiellement. Cette obligation vise à préserver la confiance et à éviter toute tromperie, volontaire ou non.

Le AI Act introduit également un cadre inédit pour les General Purpose AI (GPAI), comme les grands modèles de langage. Ces modèles devront publier un résumé suffisamment détaillé de leurs données d’entraînement, respecter le droit d’auteur, réaliser des tests de sécurité et déclarer les modèles présentant un risque systémique.

Même si certaines modalités restent en cours de clarification, une chose est acquise : l’opacité totale n’est plus compatible avec un déploiement à grande échelle en Europe.

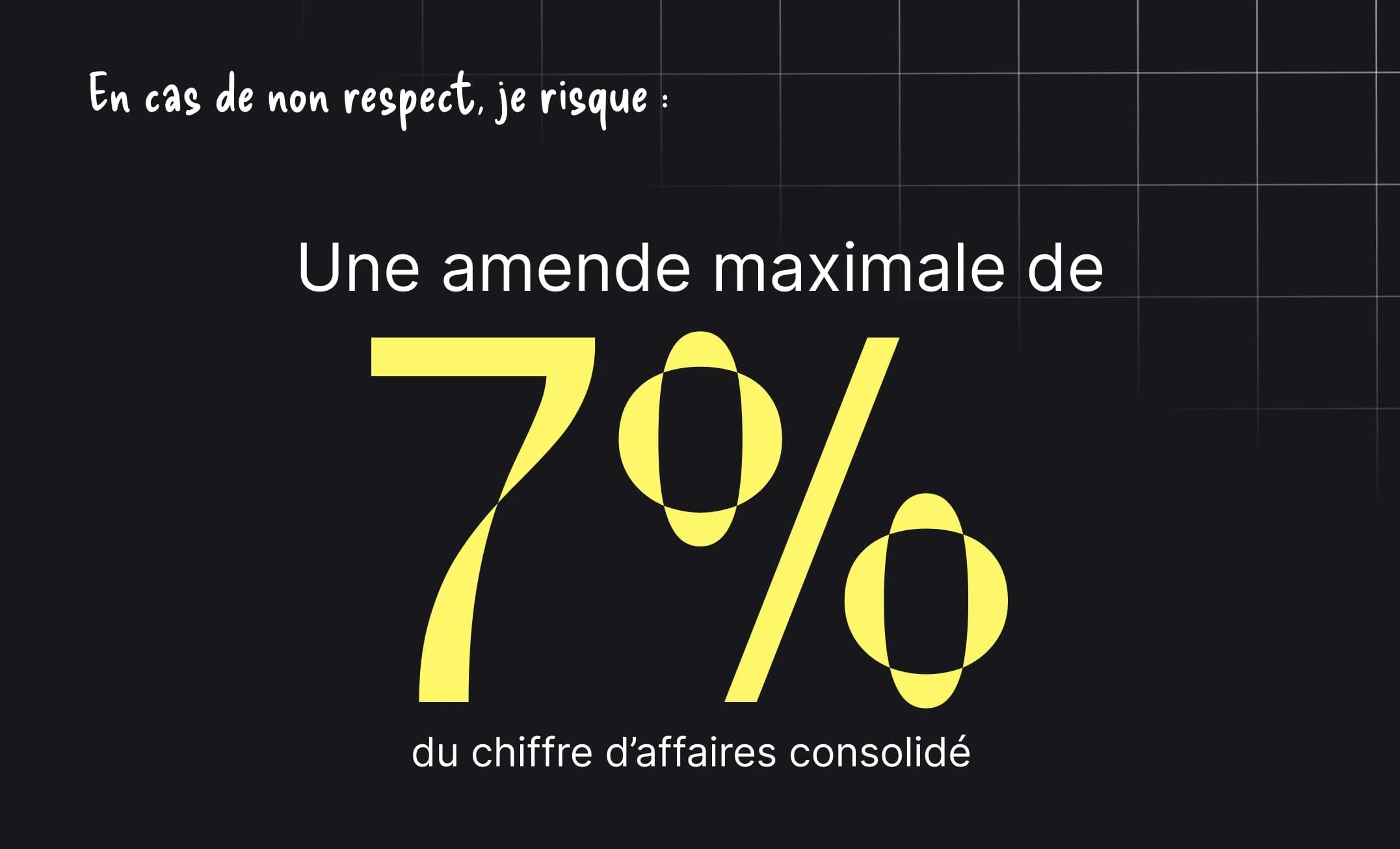

La mise en œuvre du AI Act sera supervisée par un AI Office européen. Le calendrier est progressif, avec des interdictions effectives dès les premiers mois, puis une montée en charge des obligations sur deux à trois ans.

Les sanctions peuvent atteindre jusqu’à 7 % du chiffre d’affaires mondial en cas de non-respect, plaçant le AI Act au même niveau que le RGPD en termes d’enjeux financiers et réputationnels.

Le AI Act ne signe pas la fin de l’IA en entreprise. Il marque la fin de l’IA non maîtrisée. Les organisations qui investissent dès maintenant dans la structuration des données, la traçabilité des décisions et l’intégration du contrôle humain ne se contenteront pas d’être conformes. Elles transformeront la contrainte réglementaire en avantage stratégique durable.

Passez à l’automatisation des documents

Avec Koncile, automatisez vos extractions, réduisez les erreurs et optimisez votre productivité en quelques clics grâce à un l'OCR IA.

Les ressources Koncile

Yann Lecun, son avis sur l'avenir de l'IA, et sa vision de l'AGI

Comparatifs

Comprendre la falsification de facture, ses signaux clés et les limites des contrôles classiques.

Fonctionnalité

Pourquoi les documents chauffeur et véhicule ralentissent l’intégration à grande échelle.

Fonctionnalité