Yann LeCuns Vision für die Zukunft der KI jenseits von LLMs und AGI.

Komparative

Letzte Aktualisierung:

December 22, 2025

5 Minuten

Am 13. März 2024 verabschiedete die Europäische Union den AI Act, die weltweit erste globale Verordnung zur künstlichen Intelligenz, die einen historischen Wendepunkt darstellt, der mit dem der DSGVO vergleichbar ist. Ab 2026 müssen alle Unternehmen, die KI-Systeme in Europa entwickeln, integrieren oder nutzen, nachweisen, dass ihre Modelle rückverfolgbar, erklärbar und kontrollierbar sind. Ziel ist es, der undurchsichtigen, unkontrollierten und rechtlich riskanten KI ein Ende zu setzen. Automatisierungen ohne Aufsicht, Entscheidungen, die unmöglich zu erklären sind, „Blackbox“ -Modelle: Was gestern toleriert wurde, wird zu einem großen rechtlichen, finanziellen und Reputationsrisiko. Das KI-Gesetz definiert somit die Spielregeln neu und stellt Unternehmen vor eine neue strategische Frage: Wer wird rechtzeitig bereit sein und wer wird die Kosten einer Nichteinhaltung zu spät erkennen?

Das europäische KI-Gesetz definiert KI durch Risiken. Erfahren Sie, was sich für Unternehmen ändert, welche Sanktionen sie treffen müssen und welche Entscheidungen sie treffen müssen.

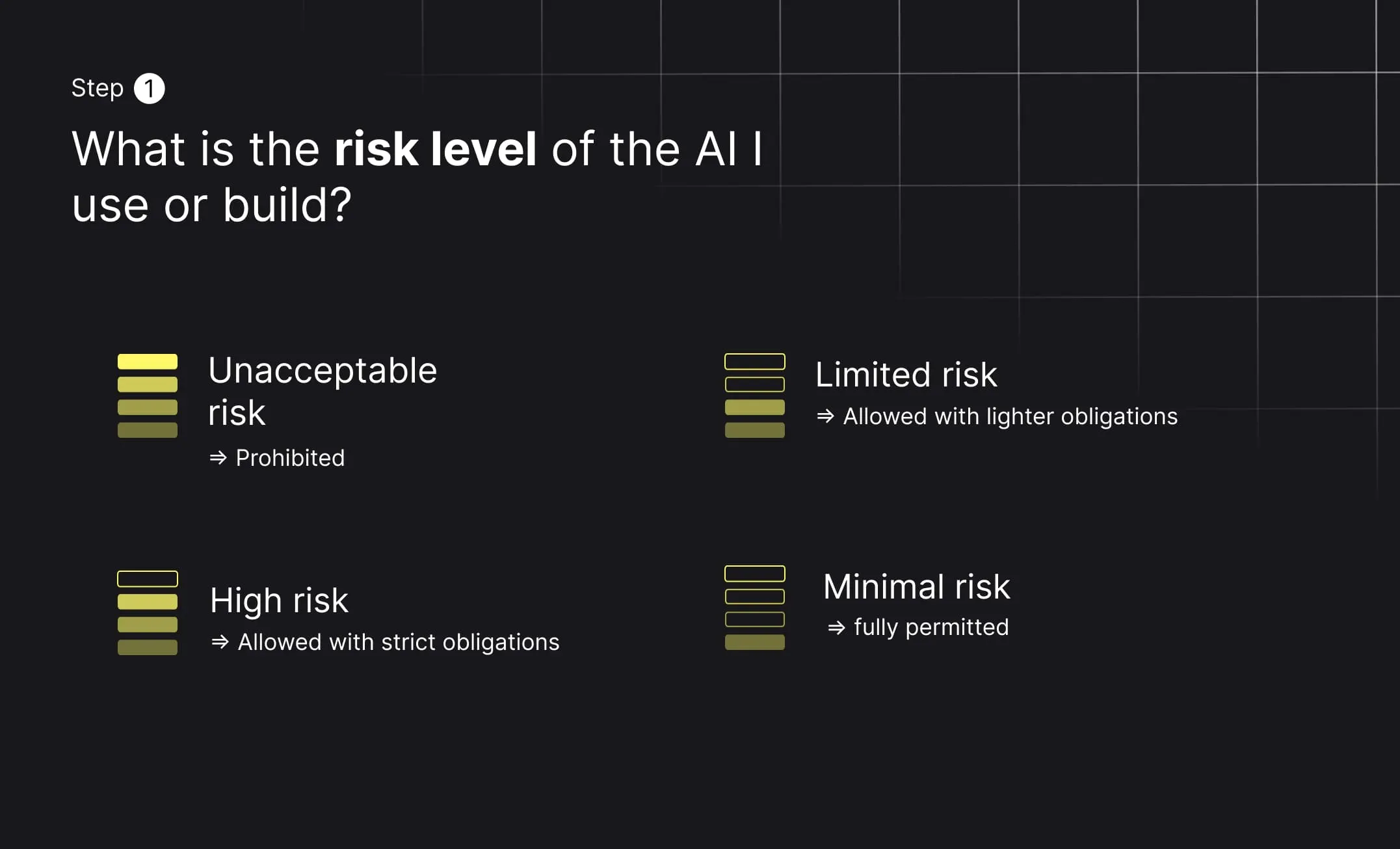

Der AI Act reguliert künstliche Intelligenz nicht einheitlich. Er basiert auf einem einfachen, aber entscheidenden Prinzip: Je höher die potenziellen Auswirkungen eines KI-Systems auf Menschen, Rechte oder die Gesellschaft sind, desto strenger sind die regulatorischen Anforderungen.

Damit vollzieht die Europäische Union einen klaren Bruch mit früheren Technologieregulierungen. Entscheidend ist nicht mehr, ob ein Unternehmen KI einsetzt, sondern wie, wo und mit welchen Konsequenzen. Im Fokus steht also weniger die Technologie selbst als ihr konkreter Einsatz und ihre Wirkung.

Viele Organisationen sprechen über den AI Act, ohne ihn tatsächlich gelesen zu haben. Das ist kaum überraschend: Der Text ist lang, komplex und stark juristisch geprägt. Dennoch ist es nicht notwendig, jede einzelne Bestimmung zu kennen, um die operative Logik zu verstehen.

Selbst die von der Europäischen Kommission veröffentlichten Zusammenfassungen bleiben für Produkt-, Tech- oder Business-Teams schwer zugänglich. Deutlich effektiver ist es, den AI Act über eine Reihe strukturierter Fragen zu erschließen – beginnend mit der Risikoklassifizierung.

Das Herzstück des AI Act ist eine Einteilung in vier Risikokategorien. Sie bildet den Ausgangspunkt jeder Compliance-Bewertung.

Unzulässiges Risiko – verboten

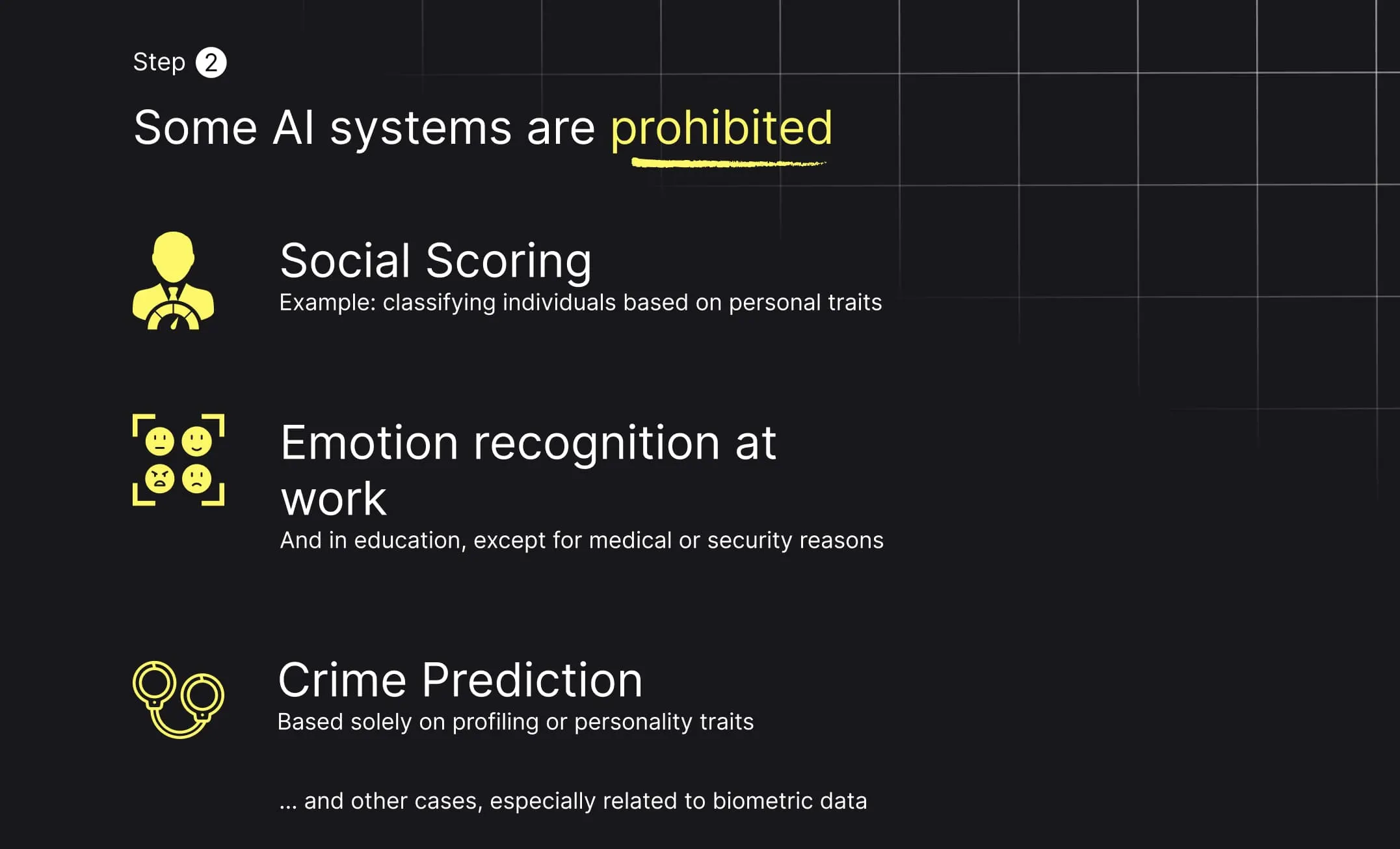

Bestimmte KI-Anwendungen sind vollständig untersagt, da sie als unvereinbar mit den Grundrechten gelten. Dazu zählen soziale Bewertungssysteme (Social Scoring), prädiktive Kriminalitätsvorhersagen auf Basis von Profiling, Echtzeit-Gesichtserkennung ohne strenge Auflagen sowie Emotionserkennung am Arbeitsplatz oder im Bildungsbereich.

Hohes Risiko – erlaubt, aber streng reguliert

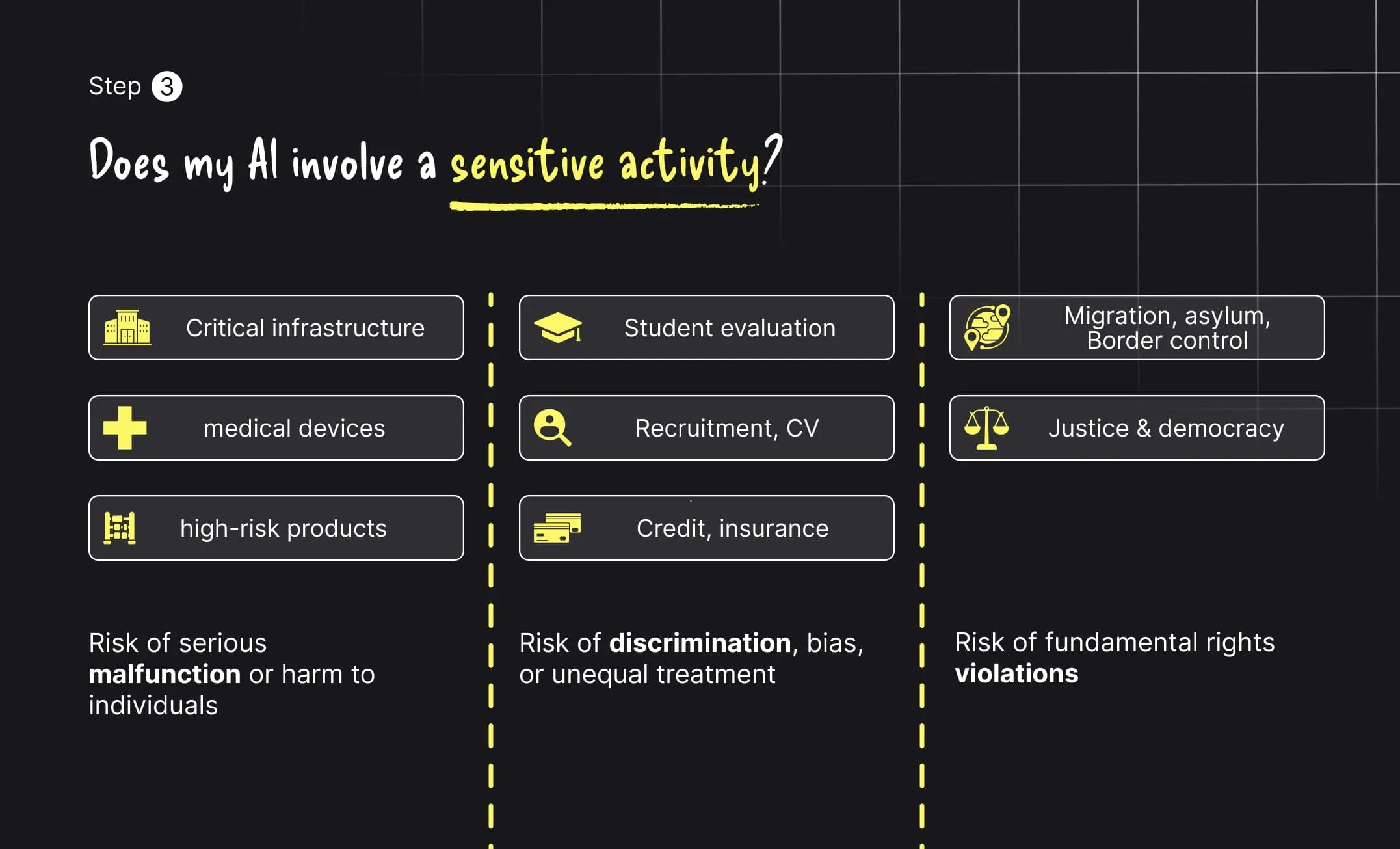

KI-Systeme mit hohem Risiko sind zulässig, unterliegen jedoch strengen Anforderungen. Sie betreffen Einsatzbereiche, in denen Fehler oder Verzerrungen erhebliche rechtliche, finanzielle oder gesellschaftliche Folgen haben können, etwa im Gesundheitswesen, im Recruiting, bei Krediten und Versicherungen, in der Justiz, bei kritischen Infrastrukturen oder in der Migrationsverwaltung.

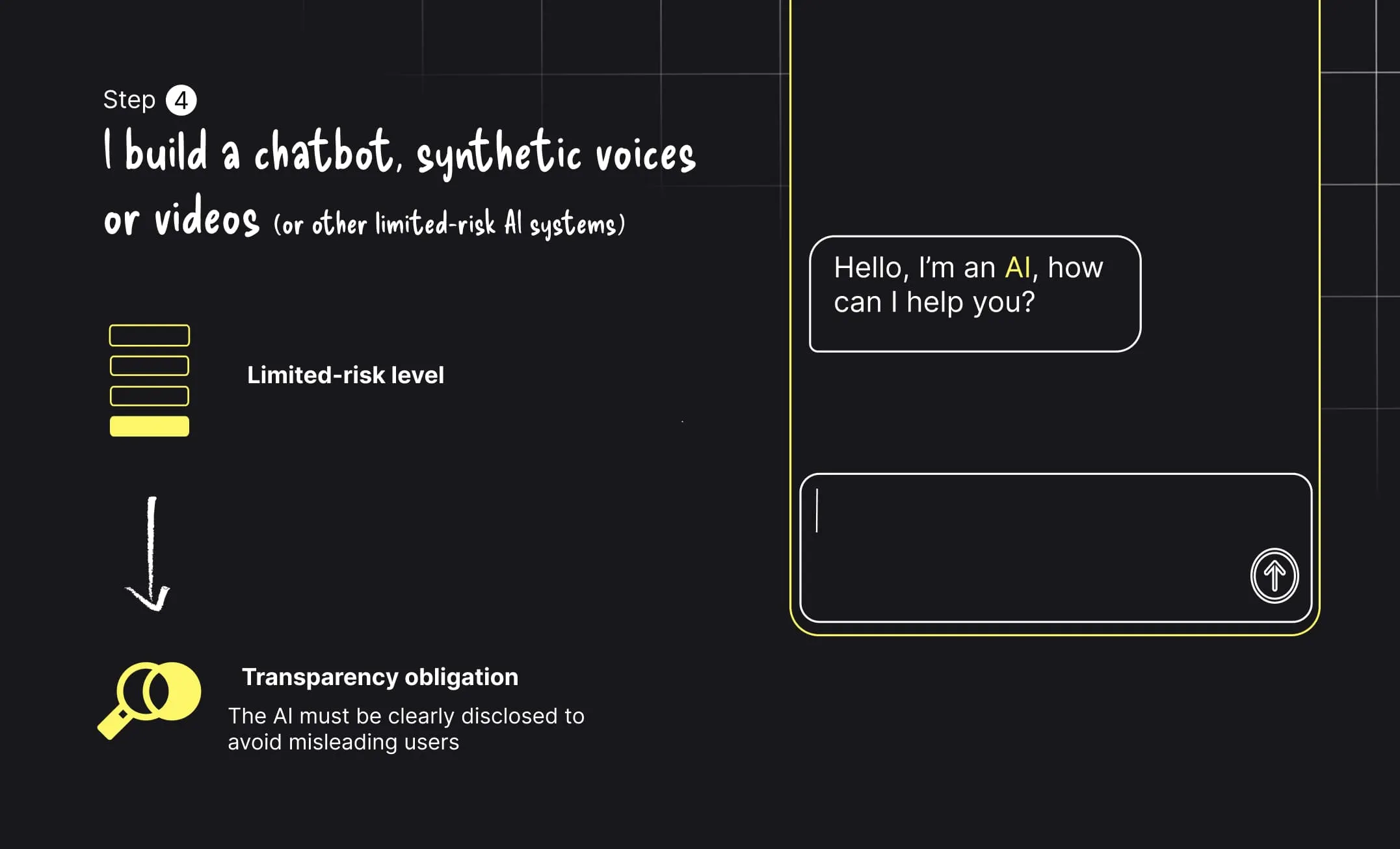

Begrenztes Risiko – Transparenzpflicht

Interagiert ein KI-System direkt mit Menschen, müssen diese klar darüber informiert werden. Das gilt insbesondere für Chatbots, synthetische Stimmen oder KI-generierte Inhalte.

Minimales Risiko – freie Nutzung

Niedrigschwellige Anwendungen wie Spamfilter, einfache Empfehlungssysteme oder Videospiele unterliegen keinen besonderen regulatorischen Vorgaben.

Bevor Unternehmen sich mit komplexen Compliance-Maßnahmen befassen, ermöglicht der AI Act eine schnelle Vorauswahl. Fällt ein Anwendungsfall unter die verbotenen Praktiken, ist Compliance keine Option – das System muss eingestellt oder grundlegend überarbeitet werden.

Für die meisten Unternehmen ist dieser Schritt beruhigend. Wenn Ihre KI weder Menschen bewertet, Verbrechen vorhersagt noch Emotionen von Mitarbeitenden analysiert, können Sie zum nächsten Schritt übergehen. Diese Klarheit nimmt viel von der anfänglichen Unsicherheit.

Kritisch wird es dort, wo KI in sogenannten sensiblen Bereichen eingesetzt wird. In vielen dieser Anwendungsfälle verarbeitet KI große Mengen unstrukturierter oder teilstrukturierter Dokumente, etwa medizinische Unterlagen, Identitätsnachweise, Finanzdokumente oder Verwaltungsakten. Diese Informationen müssen häufig zunächst mittels OCR in verwertbare Daten umgewandelt werden, was die Anforderungen an Genauigkeit, Nachvollziehbarkeit und menschliche Kontrolle im Rahmen des AI Act zusätzlich erhöht.

Kritische Infrastrukturen, medizinische Geräte oder Hochrisikoprodukte können physische Schäden verursachen. Systeme zur Leistungsbewertung von Schülern, im Recruiting, bei der CV-Selektion oder in Kredit- und Versicherungsprozessen bergen Diskriminierungsrisiken. Anwendungen in Migration, Justiz oder demokratischen Prozessen betreffen unmittelbar Grundrechte.

In diesen Kontexten ist KI kein reines Optimierungswerkzeug mehr, sondern ein entscheidungsrelevanter Akteur, der klaren Regeln unterliegen muss.

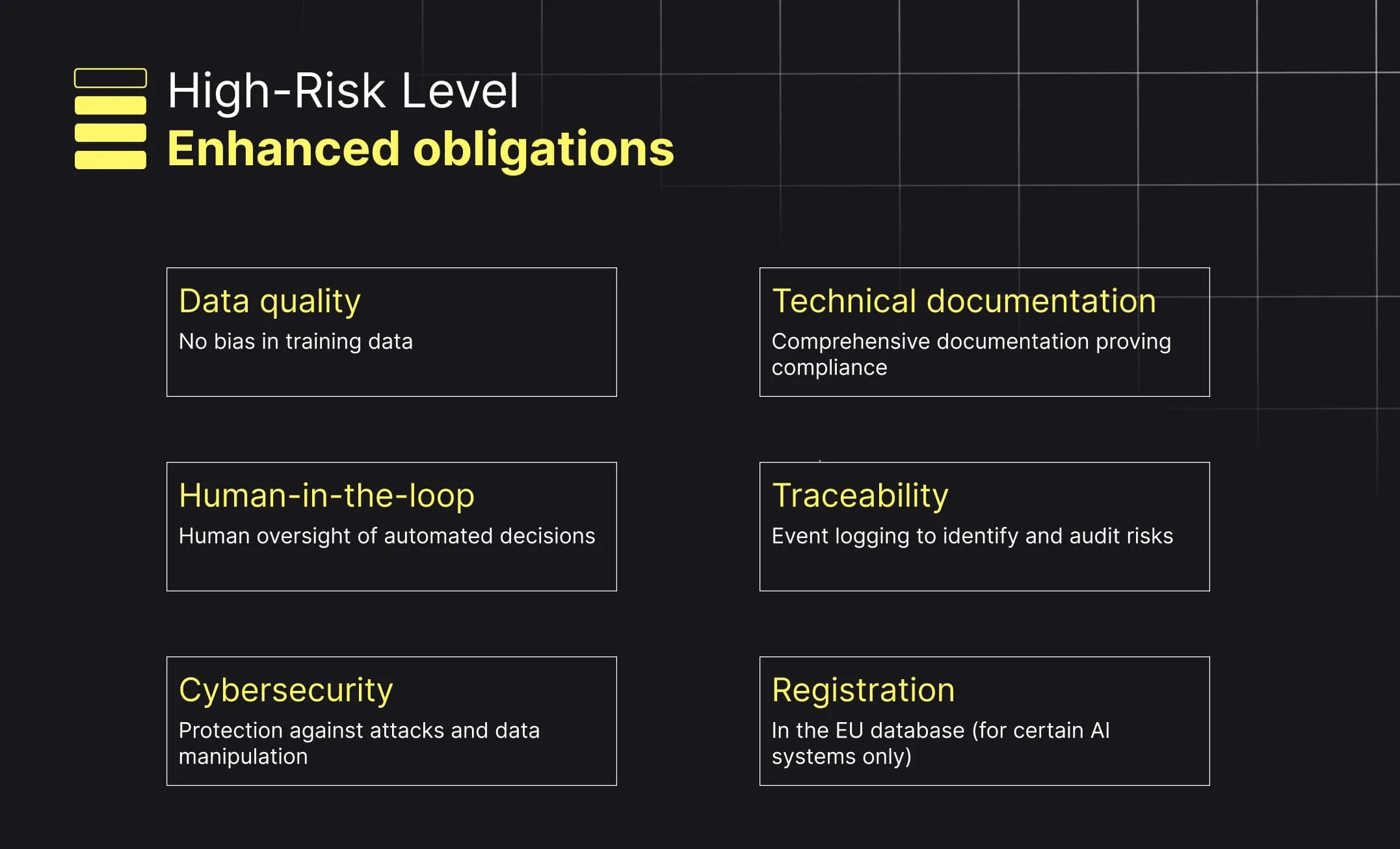

Wird ein KI-System als hochriskant eingestuft, lässt der AI Act kaum Interpretationsspielraum. Die Anforderungen sind klar definiert und operativ umsetzbar.

Unternehmen müssen die Qualität ihrer Trainingsdaten sicherstellen und Verzerrungen minimieren, eine umfassende technische Dokumentation vorhalten, eine wirksame menschliche Aufsicht gewährleisten, Entscheidungen nachvollziehbar protokollieren, ihre Systeme vor Cyberangriffen schützen und bestimmte Modelle in einer EU-Datenbank registrieren.

Diese Vorgaben verändern die Art, wie KI-Systeme entwickelt werden. Bevorzugt werden strukturierte, auditierbare und steuerbare Architekturen – und nicht mehr intransparente „Black-Box“-Lösungen. Dieser Ansatz steht in direktem Zusammenhang mit intelligent document processing, das darauf abzielt, datengetriebene Entscheidungsprozesse nachvollziehbar, erklärbar und kontrollierbar zu gestalten.

Nicht jedes KI-Projekt fällt unter die Hochrisiko-Kategorie. Viele gängige Anwendungsfälle, insbesondere im Bereich der generativen KI, gelten als begrenztes Risiko.

Hier ist die wichtigste Anforderung eindeutig: Transparenz. Nutzer müssen klar erkennen können, dass sie mit einer KI interagieren oder KI-generierte Inhalte konsumieren. Ziel ist es, Vertrauen zu schaffen und Irreführung zu vermeiden.

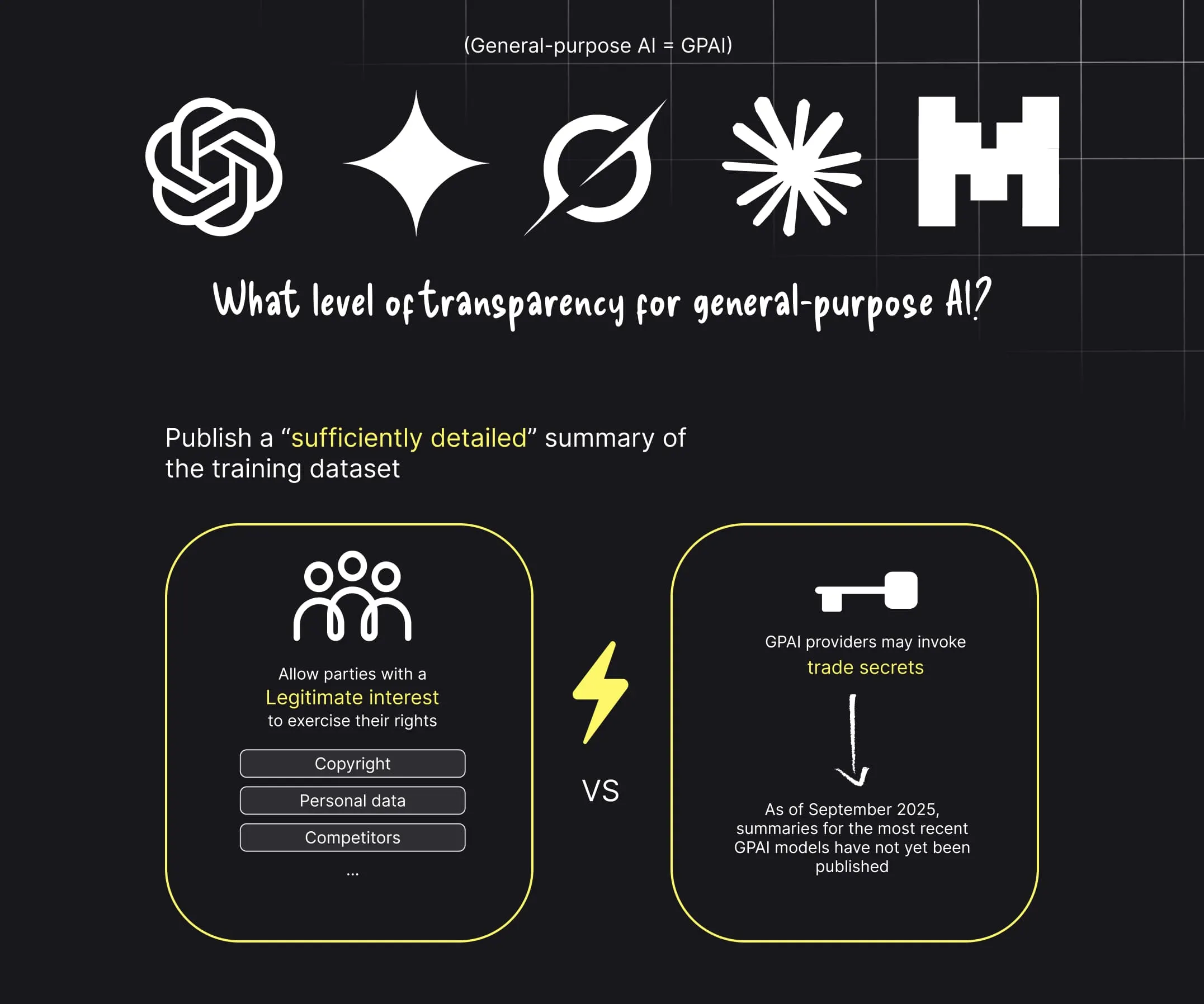

Der AI Act führt zudem einen eigenen Rahmen für General Purpose AI (GPAI) ein, etwa für große Sprachmodelle. Diese Modelle müssen ausreichend detaillierte Zusammenfassungen ihrer Trainingsdaten veröffentlichen, das Urheberrecht beachten, Sicherheitstests durchführen und besonders leistungsstarke Modelle als systemisches Risiko deklarieren.

Auch wenn einige Details noch konkretisiert werden, ist eines klar: KI-Modelle mit breitem Einsatzspektrum können in Europa künftig nicht mehr vollständig intransparent betrieben werden.

Die Durchsetzung des AI Act wird von einem europäischen AI Office überwacht. Die Umsetzung erfolgt schrittweise: Zunächst greifen Verbote unzulässiger Praktiken, anschließend Pflichten für GPAI, und schließlich die vollständige Compliance für Hochrisiko-Systeme innerhalb von zwei bis drei Jahren.

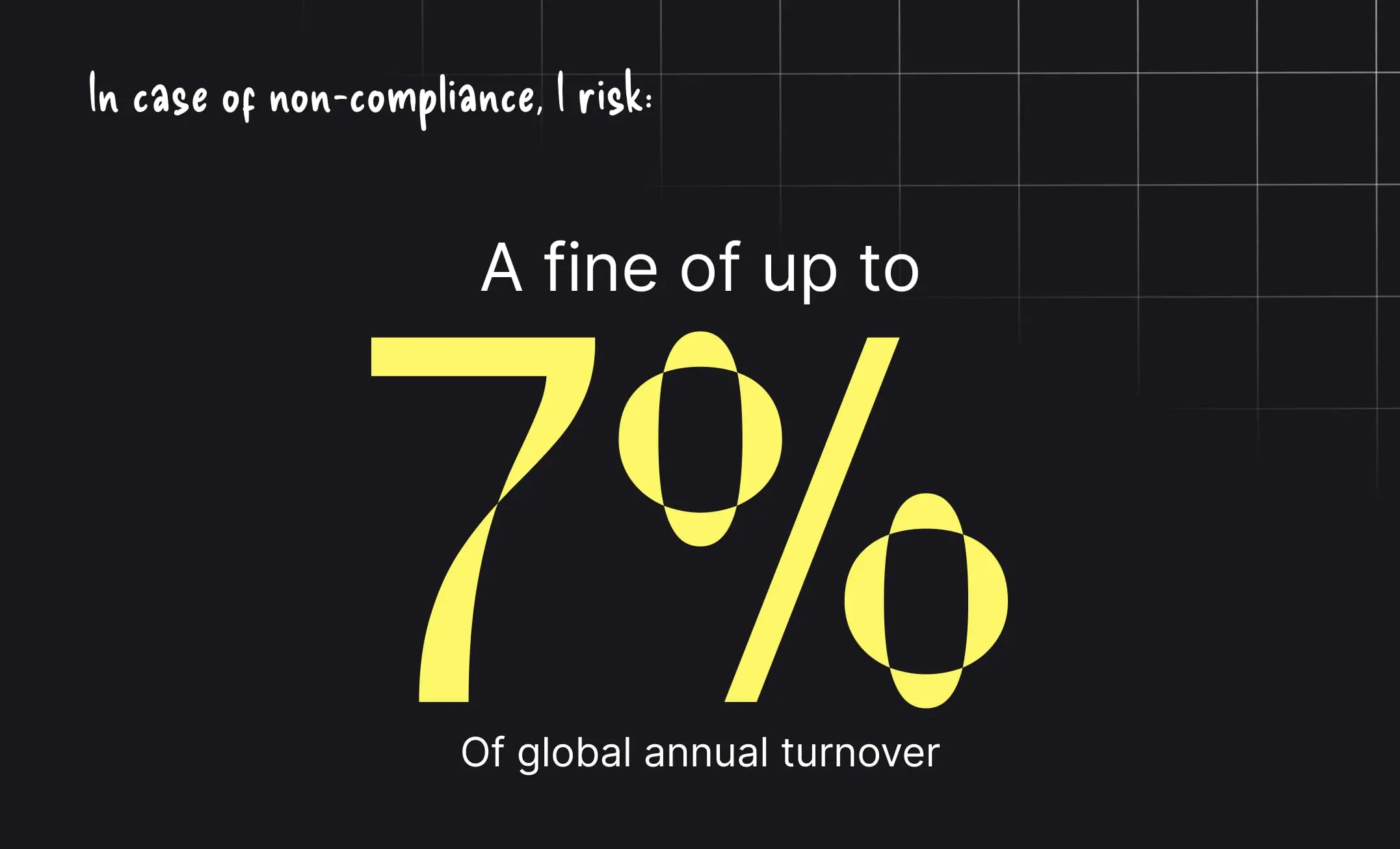

Die möglichen Geldbußen können bis zu 7 % des weltweiten Jahresumsatzes betragen und stellen den AI Act auf eine Stufe mit der DSGVO – sowohl finanziell als auch reputativ.

Der AI Act bedeutet nicht das Ende von KI in Unternehmen. Er markiert das Ende unkontrollierter KI. Organisationen, die frühzeitig in strukturierte Daten, nachvollziehbare Entscheidungen und menschliche Kontrolle investieren, werden nicht nur konform sein. Sie verschaffen sich einen nachhaltigen strategischen Vorteil.

Wechseln Sie zur Dokumentenautomatisierung

Automatisieren Sie mit Koncile Ihre Extraktionen, reduzieren Sie Fehler und optimieren Sie Ihre Produktivität dank KI OCR mit wenigen Klicks.

Ressourcen von Koncile

Yann LeCuns Vision für die Zukunft der KI jenseits von LLMs und AGI.

Komparative

Wie Rechnungsbetrug funktioniert, typische Warnsignale und warum klassische Kontrollen nicht ausreichen.

Funktion

Warum Fahrer- und Fahrzeugdokumente die Integration im großen Maßstab verlangsamen.

Funktion